소셜 로봇의 초기 기대치에 관한 연구 : 언어적, 비언어적 상호작용을 중심으로

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

로봇공학의 발전과 함께 로봇에 대한 거부감 없는 수용을 위하여 사용자의 기대와 관련된 연구가 다양한 분야에서 진행되어 왔다. 그러나 소셜로봇의 일상생활 도입이 가까워지면서 구체적인 맥락 안에서 사용자의 기대 차이를 확인하는 연구가 필요하다. 본 연구에서는 카페 안에서 소셜 로봇이 커피를 전달하는 맥락을 선정하여 사용자의 인지된 물리적 역량, 사회적 역량을 3단계 시간 모델로 측정해 사용자의 기대 차이를 알아보았다. 그 결과, 사용자들은 로봇을 처음 마주했을 때보다 초기 소셜로봇에 대해 높은 기대치를 가지고 있었고, 이러한 기대차이는 로봇과 짧은 상호작용 이후에 또 다시 다른 양상을 보이는 것을 확인했다.

Abstract

Along with advances in robotics, prior research has been conducted in various fields due to differences in users' expectations in accepting robots. However, social robots are rapidly introducing, research applying specific contexts to identify users' expectations is necessary. In this study, the perceived physical and social capabilities are measured in three stages as factors that measure users' expectation gap within the context of delivering coffee within a cafe. As a result, users had high expectations for social robots earlier than when they first encountered the robot, and these expectations showed another pattern after a short interactions with the robot.

Keywords:

Social Robot, Acceptance, Expectation gap, Interaction Design, Perceived Capability키워드:

소셜 로봇, 수용의도, 기대 차이, 인터랙션 디자인, 인지된 역량Ⅰ. 서 론

소셜로봇은 사회적으로 용인되는 방식으로 인간과 상호작용하며, 인간이 이해할 수 있게 의도를 전달하고 인간 혹은 로봇과 협업해 문제를 해결할 수 있는 능력을 갖춘 로봇으로 정의된다.[1] 로봇 공학 분야는 빠르게 확장되고 있으며, 전문가들은 조간만 소셜로봇이 비서, 보조원, 도우미, 동반자로서 일상생활에 일부가 될 것이라 내다보고 있다.[2] 국내에서는 대표적으로 2018년 LG전자가 개발해 인천공항에 배치된 안내용 소셜로봇 ‘에어스타’가 잘 알려져 있다. 또한, IT기술 연구가 활발히 이루어지고 있는 판교의 식당가에서는 서빙을 도와주는 배달의 민족의 소셜로봇 ‘딜리’, 네이버 랩스의 소셜로봇 ‘Around C’가 곧 상용화를 앞두고, 사용자 테스트를 진행 중이다. 이처럼 기존에 없던 다양한 소셜 로봇이 개발되고 있는 가운데, 새로운 기술을 사용자가 거부감 없이 수용할 수 있게 설계하는 것이 중요하다.

로봇의 외관, 행동, 및 상호작용을 통한 사용자의 인식이 로봇의 수용에 영향을 미치기 때문에 HRI (Human- Robot Interaction) 분야에서 이에 관한 많은 연구가 진행되고 있다.[3] 예를 들어 사용자의 로봇에 대한 선호도는 직업과 상황에 따라 달라지지만, 단순히 기능을 강조한 설계를 한 로봇보다는, 감정표현 같은 인간과 유사한 특징이 있을 때 사용자의 인식이 올라간 것으로 밝혀졌다.[4]. 또한, 다른 새로운 기술과 다르게 소셜로봇은 이미 공상과학 영화를 통해 대중들에게 다양한 맥락에서 자주 노출되어 왔다. 그렇기에 사용자들은 실제 로봇 사용 경험이 없음에도 로봇에 대한 기대치가 상대적으로 높다.[5] 이로 인해 사용자가 실제 소셜로봇을 마주하고 상호작용 했을 때, 기대했던 것과 실제 능력 사이에서 차이를 경험하게 되고 이것은 부정적인 사용자 경험으로 이어질 수 있다. 따라서 소셜로봇의 원활한 수용을 위해서는 무엇보다도 사용자에게 내재되어 있는 기대치를 측정하고, 로봇을 마주했을 때 이러한 기대치가 어떻게 변하는지를 측정하는 것이 중요하다.

이러한 기대차이에 관한 선행연구에서는 전반적인 의사소통 맥락에서 사용자의 기대치 변화를 측정했다. 하지만 대부분의 연구가 실험실 내에서 진행되고, 특정 상황이나 환경적 맥락을 구체적으로 가정해서 진행되어 있지 않다. 소셜로봇은 일상으로의 도입이 매우 가까워졌기 때문에, 실제 상황을 가정하고, 구체적인 맥락 안에서 사용자의 기대 차이를 측정하는 것이 매우 중요하다. 본 연구에서는 현재 상용화를 앞두고 있는 카페의 소셜 로봇을 구체적인 환경 맥락으로 설정하고 이 때 사용자가 가지고 있던 초기 기대치와 실제 로봇을 마주할 때 기대치의 비교를 통해 사용자의 기대 차이를 알아볼 것이다. 뿐만 아니라, 실제 로봇을 마주한 후, 상호작용 방식 조건에 따라 두 가지의 상이한 인터랙션을 경험하고 이것이 사용자의 기대에 어떤 영향을 주는지 살펴보고자 하였다.

Ⅱ. 이론적 배경

2-1 기대와 정신모형

인간은 어떤 대상이든 그것과 상호작용할 때마다 자신의 행동에 바탕이 되는 기대치를 형성하게 된다. 이러한 기대치 형성은 인간과 인간의 상호작용뿐만 아니라 인간과 로봇의 상호작용(HRI) 분야에서도 동일하게 적용된다.[6] 선행 연구에 따르면, 사용자가 로봇의 능력에 기대치를 형성하는 것이 실제 로봇이 무엇을 할 수 있는지에 대한 믿음에 영향을 미친다고 보고되었고, 로봇에 대한 기대치를 높게 형성한 사람들은 기대치를 낮게 형성한 사람들보다 로봇의 능력에 대해 더 실망하게 되고 긍정적인 평가를 이끌어내지 못했다.[7,8] 따라서 소셜로봇을 설계할 때 사용자의 수용, 사용 의지에 대한 부정적인 영향을 방지하기 위해서는 사용자의 기대를 미리 이해하고, 충족시키는 것이 중요하다[9,10,11] 본 연구에서는 새로운 로봇이 사용자에게 처음 수용되는 맥락에서 소셜 로봇에 대한 사용자의 기대치가 어떻게 변화하는지에 대해 살펴보고자 한다.

선행연구에서는 로봇에 대한 초기 기대차이를 측정하기 위해 프라이밍 효과(Priming effect)를 사용하였다. 프라이밍 효과는 먼저 처리한 정보에 의해 떠오른 특정 개념이 뒤에 이어지는 정보의 해석에 영향을 미치는 현상이다.[12] 기존 HRI 연구에서 외관, 기능표 등 시각적인 요소를 미리 보여줌으로써 사용자의 인식에 변화가 있음을 입증했다. [13]에서는 실험 참가자에게 미래에 상호 작용할 로봇의 정지된 비디오 화면을 보여주고 프라이밍 전후 사용자의 불확실성, 사회적 실재감의 변화를 측정했다. 또 다른 연구에서는, 로봇의 기술 사양이 적혀 있는 전단지를 통해 로봇에 관해 프라이밍을 진행한 후, 완벽히 동일한 로봇을 사용자가 조작 했을 때 사용자가 느끼는 로봇 속도, 중량, 전력, 안정성에 대해 측정했고, 사용자 인식에 변화가 있음을 도출했다.[14] 이는 로봇의 능력에 변화가 없더라도 프라이밍을 통해 사용자의 인식이 변화될 수 있다는 것을 보여준다.

프라이밍 효과는 단순히 정지된 영상이나 전단지 이외에도 실제 짧은 상호작용을 통해 살펴볼 수 있다. [15]의 연구에서는 상호작용 대상(소셜 로봇 / 인간)과 상호작용 시점(초기 기대 / 시각 장면 제시/ 짧은 상호작용)에 따라 사람들의 사회적 존재감과 불확실성이 어떻게 달라지는지 살펴보았다. 그 결과, 초기 기대나 시각 장면을 제시했을 때는 상호작용 대상이 소셜 로봇이든 인간이든 차이가 없었다. 하지만 짧은 상호작용을 한 이후에는 소셜 로봇과 상호작용을 한 조건이 사람과 상호작용을 한 조건보다 낮은 불확실성과 높은 사회적 존재감을 보이는 것을 알 수 있었다. [11]은 로봇과의 상호작용 전, 후의 차이를 Adaption Gap이라 정의하고, 이러한 차이가 사용자의 행동에 크게 영향을 미친다고 보고하였다.

로봇에 대한 기대와 관련하여 함께 고려해 볼 수 있는 것은 정신모형(Mental Model)이다. 정신모형은 시스템의 목적이나 형태, 기능 및 관련된 상태 구조에 대한 사용자의 지식을 의미한다.[16] 사용자는 정신모형을 통해 시스템 행동에 대한 예측을 하며 어떻게 작동해야 할지를 결정한다. 이 정신모형은 기억이론과 연결 지어 크게 두가지로 구분할 수 있는데, 첫째는 선언 지식을 통해 생성되는 일반 정신모형(General Mental Model)이고 두 번째는 절차 지식을 통해 생성되는 적용된 정신 모형(Applied Mental Mode)이다.[17] 다시 말해, 상호작용 이전에 교육을 통해서든 매뉴얼을 통해서 선언 지식으로 시스템에 대한 정신모형을 세우는 것이 일반 정신모형이고, 실제 상호작용을 통해 시스템의 작동을 경험하면서 절차 지식으로 시스템에 대한 정신모형을 획득하는 것이 적용된 정신모형이다. 핵심은 일반 정신모형과 적용된 정신모형간의 불일치가 사용자의 신뢰와 수용에 부정적인 영향을 미친다는 것이다.[18] 기대와 관련된 연구들과 종합적으로 고려하면, 사용자는 로봇에 대해 자신의 기대를 가지고 있으며 이 기대치는 로봇과의 짧은 상호작용 이후에 변화할 수 있다. 이것은 절차 지식을 쌓기에는 충분한 기간이 아니므로 로봇의 외관이나 몇 가지 상호작용 방식을 통해 일반 정신 모형을 획득하는 것과 관련지어 생각할 수 있다. 중요한 것은 이렇게 형성된 기대치와 실제 로봇의 능력의 차이가 발생하면 적용된 정신모형을 만드는 과정에서 사용자의 수용의도나 신뢰에 부정적 영향을 줄 수 있다는 점이다.

따라서 먼저 사용자가 로봇에 대해 가지는 기대가 어떻게 형성되는지 살펴볼 필요가 있다. 또한 이 기대가 초기, 시각적인 경험, 짧은 상호작용을 거치면서 어떻게 달라지는지 살펴봐야 할 것이다. 본 연구에서는, 선행연구에서 사용한 기대에 대한 프라이밍 효과를 살펴보고자 하며 3단계의 시간 모델을 적용하고자 한다. 구체적으로, 사용자의 소셜 로봇에 대한 기존 초기 기대(baseline)가, 시각자료 제시(visual prime), 그리고 짧은 상호작용 이후(post interaction) 사용자 경험 측면에서 어떻게 달라지는지를 측정할 것이다.

2-2 로봇의 수용의도

인공지능의 발전으로 로봇기술이 급격하게 발전하고 있으며, 사용자들은 곧 일상생활에서 많은 소셜 로봇과 상호작용하게 될 것이다. 급격하게 발전한 새로운 기술이 일상생활에 도입되는 만큼 이는 사용자에게 쉽게 수용되지 않을 수 있다는 점을 고려해야 한다.[19] 그렇기에 로봇을 설계할 때 사용자의 수용에 대해 이해하는 것은 중요한 요소이다.[9] HCI나 UX분야에서는 기술수용모델(TAM: technology acceptance model)을 사용하여 특정 기술에 국한되지 않고 전반적인 사용자의 기술 수용에 영향을 미치는 요인에 대해 연구를 많이 진행해 왔다. [20] 하지만 이는 로봇의 수용과는 거리가 있어 본 연구에서는 발전된 형태의 다른 모델을 도입하였다. 로봇 수용에 관한 선행 연구에 따르면 사용자의 수용에 영향 미칠 수 있는 로봇의 특성을 로봇 기능(function), 사회적 능력(social ability), 형태(form)의 세가지로 제시했고, 이러한 특성에 대한 사용자의 인식이 수용정도에 영향을 준다고 하였다.[21] 즉, 단순히 로봇의 기술적 향상이 수용을 증가시키는 것이 아니라, 로봇에 대한 사용자의 여러 가지 인식을 변화시키는 것이 중요함을 보여준다. 특히, 로봇의 기능 이외에도 사회적 능력이 중요함을 알 수 있는데 선행 연구에서 제시한 사회적 능력은 감정 표현, 언어 및 대화, 비언어적 신호를 포함한다. 이것은 로봇이 사람과 상호작용할 때 사람과 사람 간의 상호작용 방식과 유사한 정도가 사용자에게 중요한 수용 기준이 될 수 있음을 시사한다.

로봇에 대한 기대이론과 연결하여 고려해보면, 로봇 기능의 경우는 기능을 설명하는 매뉴얼을 보거나 기능을 경험할 수 있는 인터랙션을 통해 정신모형이 형성될 수 있다. 그리고 그렇게 형성된 정신모형을 바탕으로 다른 기능들에 대한 예측이나 기대도 가지게 된다. 사회적 능력의 경우 로봇이 사용자에게 제공하는 상호작용 방식을 통해 (예를 들어, 언어적 표현을 한다든지, 감정 표현을 하는 형태) 사용자는 로봇에 대한 정신모형을 형성하고 그 로봇의 전반적 기능에 대한 예측, 기대를 가지게 된다. 본 연구에서는 로봇의 사회적 능력에 초점을 맞추어 살펴보고자 한다. 이를 위해 로봇의 기능은 카페에서 서빙을 하는 것으로 동일하게 설정한 후, 로봇이 가진 사회적 능력을 조작하여 사용자의 기대와 인식에 영향을 미치는지 살펴보고자 하였다. 그리고 사회적 능력의 조작을 위해 로봇이 언어적 표현을 하는지, 비 언어적 표현을 사용하는지 구분하여 각기 다른 조건 하에서 사용자의 기대 정도에 어떠한 영향을 미치는지 알아보고자 하였다.

로봇과의 상호작용 방식에 대한 선호도를 조사한 선행연구에 따르면, 로봇이 언어, 즉 말을 구사하는 것이 사용자들이 가장 선호하는 상호작용 방식이다. 다만 사용자의 선호와 다르게 언어적 상호작용은 로봇에 대한 사용자의 인식에 편향을 발생시킬 수 있다. [22]에 따르면, 사용자는 로봇을 하나의 다른 사람처럼 이해하고 관계를 맺고 의인화 하려고 한다. 언어사용은 이러한 의인화를 촉진하고 사용자가 실제로 존재하지 않은 능력을 인식하게 할 수 있다[23]. 예를 들어 로봇이 언어를 구사하면, 사용자는 자연스럽게 언어를 이해할 수 있다고 생각한다. [10]의 실험에서는 로봇이 단순히 인간이 가지고 있는 몇 가지 능력(턴 테이킹, 말하기 등)을 보여줌으로써 의도치 않게 로봇의 전체적인 능력에 대한 정신모형이 잘 못 형성된다는 것을 확인하였다. 실제 로봇의 능력보다 훨씬 높은 수준의 정신모형을 형성하게 된 것이다. 이러한 잘못 형성된 정신모형은 다른 기능에 대해서 더 높은 기대를 가지게 되고 이것이 실제 능력을 경험한 이후 좌절로 이어질 수 있다. 그렇기에 소셜로봇 설계에 있어 언어적 상호작용은 조심스럽게 도입되어야 할 것이다.

로봇의 비언어적 표현은 시선, 고개 끄덕임, 빛 등이 포함되는데 이는 대화를 제어하거나 로봇의 의도를 전달하기 위한 부가적인 도구로 사용되어 왔다. 예를 들어 [24]에서는 최초로 비언어적 표현을 사용한 로봇을 소개하였으며, 이 로봇은 눈을 깜박거림으로써 대화를 시작할 준비가 되어 있음을 알렸다. 또 다른 선행 연구에서는 LED 조명의 색을 사용해 로봇의 감정을 표현하는 방식이 사용자의 정서적 경험에 영향을 미친다고 보고했다.[25] 로봇의 언어적 표현과 비언어적 표현을 직접적으로 비교한 연구는 찾기 어렵지만, 선행연구들을 종합하면 로봇이 언어적 표현을 할 때 사람들은 그 로봇의 전반적 기능에 대해 더 높은 기대를 하게 될 것으로 보인다. 본 논문에는 언어적 표현과 비언어적 표현을 조작하기 위해, 3단계 시간 모델 중 짧은 상호작용을 상호작용 방식에 따라 언어적 표현을 하는 조건과 비언어적 표현을 하는 조건으로 나누었다. 이를 통해 상호작용 이후 조건에 따라 사람들의 소셜 로봇에 대한 기대가 어떻게 다른지 살펴보고자 한다.

2-3 인지된 역량

선행연구에서는 로봇 특성에 따른 사용자의 기대와 인식을 측정하기 위한 변수로 인지된 역량을 측정했다.[26, 27] 인지된 역량이란 사용자가 로봇이 수행할 수 있다고 믿는 일로 정의된다. [26]의 연구에서는 인지된 능력이 높을 때, 로봇이 실수 할 경우에 신뢰도가 더 하락하는 것을 보였다. 이는 앞서 언급했듯이 로봇에 대한 잘못된 기대가 실제 능력과 비부합하면서 발생한 결과다. 또 다른 연구에서는 로봇의 속도, 대화 방식을 다르게 한 후 상호작용을 통해 개인이 느끼는 인지된 능력이 달라지는지를 측정했다.[9] TAM과 같이 모든 기술 분야에 적용할 수 있는 모델은 기술에 대한 개인의 평가를 거시적으로 측정한다. 이 기술이 얼마나 사용하기 편리한지, 아니면 유용한지, 또는 얼마나 좋게 평가하는지 등과 같다. 하지만 인지된 역량의 경우 각각의 기술이 실제로 수행할 수 있을 것이라고 예측 가능한 능력들을 개별적으로 질문할 수 있기 때문에 세부적인 기능에 대해 사용자가 어떻게 기대하는지 파악할 수 있다는 장점이 있다. 본 연구에서는 카페라는 맥락에 존재하는 소셜 로봇에 대해 3단계 시간 모델과 상호작용 방식을 조작하여 사용자의 인지된 역량이 어떻게 달라지는지 살펴보고자 한다. 또한 인지된 역량은 인지된 물리적 역량, 인지된 사회적 역량 두 가지의 종속 변인을 통해 사용자의 정신모형 기대를 측정하고자 한다.

인지된 물리적 역량을 측정한 선행연구에서는 먼저 442명의 참가자들이 로봇에게 기대할 수 있는 물리적 역량을 설문조사를 통해 도출했다.[27] 본 논문에서는 카페라는 맥락에서 사용될 수 있는 8개의 항목을 선택하여 소셜로봇이 해당 작업을 잘 수행할 수 있을 것이라 기대하는 정도를 리커트 척도로 평가하고자 하였다.

또한 인지된 사회적 역량에 관한 선행연구에서는 소셜 로봇에 기대되는 11개의 측정 항목을 개발했다.[23] 본 논문에서는 이 중 카페 내 서빙 로봇과 관련 있는 6개의 항목을 가져와 동일하게 리커트 척도로 평가하고자 하였다.

2-4 연구 문제

본 연구에서 살펴보고자 하는 연구문제를 정리하면 다음과 같다. 먼저 카페에서 소셜 로봇이 음료를 전달해주는 상황을 사용하였다. 그리고 3단계 시간모델(초기기대/ 시각자료 제시/ 상호작용)에 따라 사용자가 소셜 로봇에 가지고 인지된 역량(인지된 물리적 역량, 인지된 사회적 역량)을 측정하여 기대 정도를 살펴보고자 하였다. 상호작용 단계에서는 언어적 상호작용과 비언어적 상호작용 조건을 나누어 소셜 로봇의 사회적 능력이 다를 때 사용자의 기대가 어떻게 달라지는지 측정하였다. 구체적으로 다음과 같은 연구문제가 존재한다.

연구문제 1. 사용자가 소셜 로봇에 대하여 기존에 가지고 있는 기대와 시각자료를 제시했을 때의 인지된 역량은 차이가 있을 것이다.

[5]에 따르면 여러 매체들의 효과로 인해 사용자가 가지고 있는 로봇의 초기 기대치가 높다고 하였고 [16]에 따르면 초기 기대치와 시각자료 제시간에 차이가 없는 것으로 보고하였다. 하지만 [15]의 연구에서 논의하였듯이 이들의 연구에 사용된 로봇은 사람의 외형과 유사하게 제작된 것이었으며(Softbank의 Pepper) 이것이 높은 초기 기대치와 유사한 기대치로 이어졌을 가능성이 있다. 본 연구에서 사용하고자 하는 소셜 로봇은 현재 상용화를 앞두고 있는 모델과 유사한 형태를 사용하였으며 해당 로봇은 사람의 외형과는 거리가 멀다. 따라서 이러한 외관이 주는 영향이 상대적으로 적다면 초기에 가지고 있는 인지된 역량이 소셜 로봇의 정적인 외형을 보여줬을 느끼는 사용자의 인지된 물리적, 사회적 역량보다 유의미하게 높을 것이다.

연구문제 2. 사용자가 로봇과 짧은 상호작용 후 느끼는 인지된 역량은 시각자료를 보여줬을 때의 인지된 역량과 차이가 존재할 것이다.

[15]의 결과에서 로봇의 시각자료를 보여줬을 때 보다 짧은 인터랙션을 경험했을 때 사회적 실재감이 증가함을 알 수 있다. 정적인 사진에서는 단순히 외형을 기준으로 인지된 역량을 평가하게 되고, 짧은 상호작용에서는 이들의 기능이나 사회적 능력을 함께 고려하여 인지된 역량을 평가하게 된다. 외관이 주는 기대보다 소셜 로봇의 기능과 사회적 능력이 더 높은 기대를 준다면 인지된 역량 역시 높게 평가될 것이다.

연구문제 3. 짧은 상호작용 시, 언어적 상호작용을 경험할 때와 비언어적 상호작용을 경험할 때 사용자의 인지된 역량에 대한 기대 차이가 있을 것이다.

언어적 표현을 하는 경우에 사회적 능력이 더 높게 평가되므로 본 연구문제는 구체적인 방향성 또한 예측이 가능하다. [10, 23]의 연구결과를 참조하면, 언어적 표현을 할 때 사용자는 실제로 존재하지 않는 능력에 대한 기대도 하게 되므로 인지된 역량에 대한 평가 역시 증가할 것으로 보인다.

Ⅲ. 연구설계

3-1 실험 참가자

본 실험에 참가한 실험 참가자는 만 19세 이상의 영상 시청에 어려움이 없는 사람으로 선정하였다. 모두 64명이 참가하였으며 경험하지 않은 로봇에 대한 초기 기대 차이를 측정하는 실험이기 때문에, 사전에 소셜로봇과의 상호작용을 경험한 참가자(N = 20, 31.3%)는 실험 데이터에서 제거하였다. 분석에 사용된 실험 참가자(N = 44)는 남성 21명, 여성 23명으로 평균 연령은 25.11세(SD = 3.21)였다. 모든 참가자는 시간 모델 3가지를 순서대로 경험하였으며 3단계인 인터랙션 단계에서는 상호작용 방법 조건에 따라 무작위로 언어적 상호작용 조건(N = 24)과 비언어적 상호작용 조건(N = 20)에 할당되었다. 실험 참가자는 실험 참가에 대한 소정의 비용을 받았다.

3-2 실험 도구

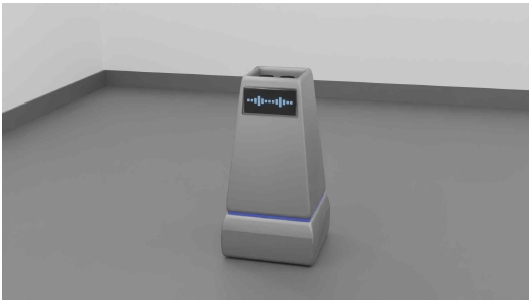

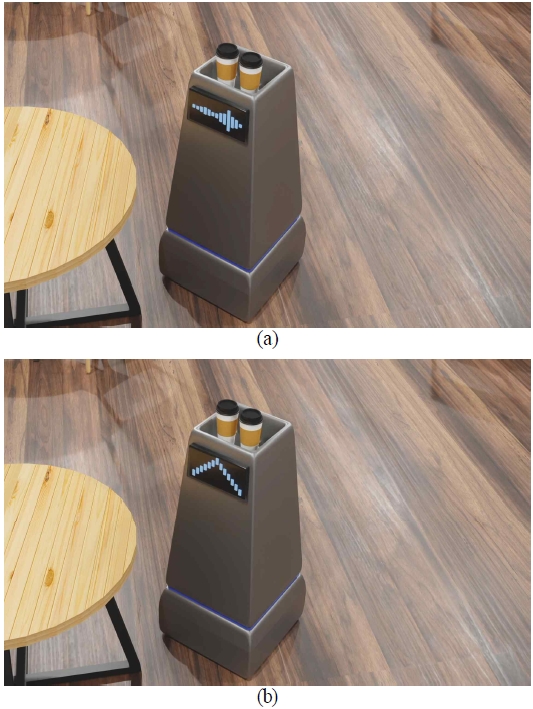

HRI(Human Robot Interaction) 연구에서 영상 시나리오를 통한 실험은 실제 실험과 더불어 높은 수준의 합의점을 도출해 낼 수 있다.[28] 이에 따라 본 논문에서도 로봇의 상호작용 방식에 따른 기대차이를 조작하기 위해 영상을 통해 실험을 진행하였다(표 2). 영상에서 사용되는 카페(그림1)과 로봇(그림2)은 3D 영상 제작 프로그램 Blender를 통해서 제작했으며, 곧 상용화될 네이버 랩스의 Around C(Caffe) 로봇과 유사하게 제작하였다. 로봇의 상호작용은 전면부의 LED 화면과 음성을 통해 구현했다. 언어적 표현의 상호작용 구현을 위해 네이버의 클로바 더빙을 사용해 '3번 고객님 위에 있는 음료를 가져가 주세요’ 라는 음성을 LED 창 위의 오디오 스펙트럼과 함께 보여주었다.(그림 3b)

비언어적 상호작용 구현은 LED 화면 위에 커졌다 작아지는 화살표와 함께 단순한 효과음을 재생했다.(그림3a) 온라인 실험 특성상 영상의 소리와 화면 크기 조절을 못 하고 넘어가는 문제를 예방하기 위해, 영상 시작 전 10초간의 안내 메시지를 통해 음량과 화면 크기 확인을 요청하고 영상이 재생되었다. 영상 시작 후 카운터 뒤(그림 1)에 음료를 탑재한 소셜 로봇이 사용자 측면으로 다가와 언어적, 비언어적 짧은 상호작용과 함께 로봇 안에 있던 음료가 사용자가 받기 편하게 위로 올라왔다.

로봇의 접근은 정면으로 다가올 경우 불쾌감을 느낀다는 선행 연구가 있어 영상 안에서 사용자의 측면으로 접근해 영상 안에서의 사용자의 시선이 로봇으로 돌아가면 5초간의 짧은 상호작용을 시작하도록 제작하였다. 영상은 실재감을 높이기 위해서 3인칭 관찰자 시점이 아니라, 사용자가 카페 테이블 옆에 앉아 있다 가정하고, 1인칭 시점에 따른 카메라 움직임을 통해 실험자가 실제 카페에서 음료를 수령하는 것과 같이 진행되었다. 영상에서는 카페에서 듣는 음악과 로봇 동작 시 발생하는 소음이 나오는데, 이 역시 사용자의 실재감을 높이는 도구로 사용되었다. 모든 조건에서 영상의 길이는 약 20초 정도였다.

종속변인으로 사용된 인지된 역량의 설문은 총 19문항이 사용되었으며 물리적 역량 8문항과 사회적 역량 6문항으로 구성되어 있다. 문항의 예시는 표 1에 제시되어 있다.

3-3 실험 절차

실험에 참가하면 먼저 연구참여에 대한 동의서를 작성하고 연구 전반에 대한 설명이 적힌 글을 제시하였다.이후 총 3단계에 걸친 설문이 시작되었다 모든 참가자는 동일하게 시간 모델 3단계를 진행하게 되었으며 자세한 순서는 다음과 같다. 첫 번째 단계에서는 참가자들에게 카페의 내부 사진(그림 1)을 보여준 다음 서빙 로봇과 상호작용 할 것이라는 말을 듣고(baseline), 개인이 사전에 가지고 있던 물리적 역량, 사회적 역량 대한 기대를 평가하도록 요청했다. 참가자들은 카페에서 서빙을 하는 소셜로봇에 대해 자신의 상상만으로 설문을 진행하였다. 두 번째 단계에서는 소셜 로봇의 외형을 정적인 사진(그림 2)을 통해 보여주고(visual interaction), 사용자가 느끼는 물리적 역량, 사회적 역량에 대해 평가했다. 마지막으로 참가자는 무선 할당된 상호작용 방법 조건에 따라 2개의 그룹으로 나뉘어 각각 언어적 상호작용을 하는 로봇(그림 3a), 비언어적 상호작용을 하는 로봇(그림 3b)의 짧은 영상을 1회 시청했다(post interaction). 이후 개인이 느끼는 물리적 역량, 사회적 역량에 대한 기대를 평가했다. 3단계가 종료되면 개인이 느꼈던 차이에 관한 주관식 문항을 적고, 실험을 종료했다.

Ⅳ. 연구 결과

4-1 설문 문항 신뢰성 검증

인지된 역량(물리적 역량, 사회적 역량) 설문 문항의 신뢰도를 검증하기 위해 Cronbach’s α 계수를 통한 신뢰도 분석을 진행하였다. 그 결과, 물리적 역량(α = .72), 사회적 역량(α = .70) 모든 항목에 대하여 Cronbach’s α 값이 0.7이상으로 분석되어 종속 변인에 대한 신뢰도가 검증되었다.

4-2 종속 변인 측정 결과

본 연구의 분석에 앞서 실험 설계의 특성 상 3단계 시간 모델 중 초기기대와 시각자료 제시 조건은 모든 참가자가 동일하게 경험하였으므로 상호작용 방법 조건에 관계없이 모든 참가자들의 점수 평균을 사용하였다 (표 3). 상호작용 방법 조건에 따라 초기기대와 시각자료 제시 조건에 차이가 있다면 이는 무선 할당에서 문제가 있는 것으로 간주될 수 있으므로 상호작용 방법 조건에 따라 초기기대, 시각자료 제시 단계의 인지된 역량 차이가 있는지 확인한 결과, 유의한 차이가 없는 것으로 나타났다.

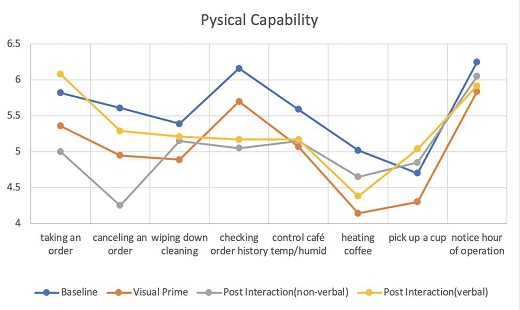

먼저, 사용자가 소셜 로봇에 대해 가지고 있던 초기 기대와 시각자료를 보여주었을 때의 차이를 보기 위해 (연구문제 1) 초기 기대와 시각자료 조건을 독립변인으로 하고 인지된 역량 두 하위요인을 종속변인으로 하여 각각 대응 표본 t 검정을 실시하였다. 그 결과, 로봇의 외형을 보여줬을 때의 물리적 역량에 대한 기대치(M = 5.03, SD = 0.92)가 참가자가 기존에 가지고 있던 로봇의 물리적 역량에 대한 기대치(M = 5.57, SD = 0.97) 보다 유의하게 낮았고 t(43) = 4.519, p > .001, 사회적 역량에 대한 기대치는 두 시간 사이에 유의한 차이가 없는 것으로 나타났다, t(43) = 1.558, p = .13.

다음으로 소셜 로봇과의 짧은 상호작용 후에 물리적 역량, 사회적 역량의 대한 기대가 시각자료를 제시하였을 때와 다른지 확인하기 위하여(연구문제 2), 시각 자료와 인터랙션 후를 독립변인으로 하고 인지된 역량을 종속변인으로 하여 대응 표본 t 검정을 실시하였다. 그 결과, 시각 자료 제시와 인터랙션 후의 인지된 역량 사이에는 차이가 없는 것으로 나타났다 (p > .05). 하지만 이를 언어적 표현을 하는 로봇과 비언어적 표현을 하는 로봇으로 구분하였을 때 상이한 결과를 얻을 수 있었다.

먼저, 언어적 표현으로 짧은 상호작용을 한 조건(M = 5.56, SD = 0.62)에서는 시각 자료를 보여준 조건(M = 5.01, SD = 1.04)보다 물리적 역량에 대한 기대치가 유의하게 높은 것을 알 수 있었다, t(23) = 3.24, p < .01. 하지만 사회적 역량은 유의한 차이가 발견되지 않았다, t(23) = 1.34, p = .19. 이와 대조적으로 비언어적 표현을 한 조건에서는 시각제시 조건과 물리적 역량, t(19) = -.58, p = .57, 사회적 역량 t(19) = -.539, p = .60 에서 모두 유의한 차이를 보이지 않았다.

마지막으로, 언어적 상호작용을 경험할 때와 비언어적 상호작용을 경험할 때의 인지된 역량 차이를 살펴보았다 (연구문제 3). 그 결과. 언어적인 로봇과 상호작용을 경험한 참가자는 비언어적인 로봇과 상호작용한 참가자들보다 물리적 역량에 대한 높은 기대치를 보였으나, t(42) = 2.62, p < .05, 사회적 역량에 대해서는 유의한 차이가 없는 것으로 나타났다.

마지막으로, 언어적 상호작용을 경험할 때와 비언어적 상호작용을 경험할 때의 인지된 역량 차이를 살펴보았다 (연구문제 3). 그 결과. 언어적인 로봇과 상호작용을 경험한 참가자는 비언어적인 로봇과 상호작용한 참가자들보다 물리적 역량에 대한 높은 기대치를 보였으나, t(42) = 2.62, p < .05, 사회적 역량에 대해서는 유의한 차이가 없는 것으로 나타났다.

Ⅴ. 논의

본 연구에서는 소셜 로봇에 대한 사용자의 기대가 3단계 시간모델과 상호작용 방법에 따라 어떻게 달라지는지 살펴보았다. 실험 결과를 바탕으로 본 연구는 소셜 로봇이 일상생활에 도입될 때 고려해야 할 사항을 사용자 기대 측면에서 논의하고자 한다.

5-1 사용자의 높은 초기 기대치를 고려한 소셜 로봇 설계

사용자의 초기 기대치에 대한 실험 결과, 사용자들은 실제 상용화될 로봇의 외관을 보여주기 전에 물리적 역량에 대한 기대치를 더 높게 가지고 있는 것으로 나타났다. 이는 선행 연구 [5]에서 실제 사용 로봇 경험에 비해 로봇 상호작용에 대해 더 높은 기대치를 가지고 있다는 주장을 뒷받침 할 수 있다. 사용자가 구체적으로 어떤 기대를 가지고 있는지 살펴보기 위해 물리적 역량에 대한 자세한 결과를 보면(그림 4) ‘주문 내역을 확인할 수 있을 것이다’, ‘카페의 운영시간에 대해 확인할 수 있을 것이다’ 항목이 6점 이상으로 높은 점수를 보였다. 이는 사용자가 소셜 로봇이라는 대상을 떠올리고 판단했을 때 주문 내역을 확인하거나 운영시간 확인같은 기능을 수행한다고 기대하는 것이다. 앞서 언급한 바와 같이 이러한 기대와 실제 기능이 일치하지 않을 때 사용자의 신뢰에 부정적 영향을 주고 좌절을 경험할 수도 있다.

따라서 카페에서 작동하는 소셜 로봇의 기능적 측면을 설계할 때 사용자의 초기 기대가 높은 기능을 실제로 수행할 수 있도록 설계를 고려한다면 사용자의 기대 차이를 어느 정도 매칭시킬 수 있을 것이다. 반면 사회적 역량에 대한 기대치는 로봇의 사진을 보여준 이후 조금 낮아지긴 했지만, 통계적으로 유의한 값이 나오지 않았다. 또한 물리적 역량에 비해 사회적 역량에 대한 기대치가 전반적으로 낮게 나왔는데, 이는 사용자들이 카페에서 일하는 소셜 로봇에게는 감정을 이해하거나, 내가 말하는 것을 이해하는 것과 같은 사회적 역량에 낮은 초기 기대를 가지고 있다고 볼 수 있다.

5-2 상호작용의 방식에 따른 사용자의 기대치 조절

본 연구에서는 소셜 로봇과의 짧은 상호작용이 기존에 사용자가 가지고 있는 소셜로봇의 역량에 대한 기대치를 변화시킬 수 있다는 사실을 보여준다. 본 실험에서 간단한 언어적 상호작용 이후 인지된 물리적 역량에 대한 기대치는 정적인 사진을 봤을 때 보다 유의미하게 증가했다. 이는 '3번 고객님 위에 있는 음료를 가져가 주세요' 라는 단 한마디의 짧은 언어적 상호작용이 의도치 않게 사용자의 기대치를 올릴 수 있다 점을 시사한다. 더 확실한 경향성을 보기 위해 구체적인 문항들의 값(그림 4)을 살펴보면, ‘컵을 수거할 수 있을 것이다’, ‘바닥 청소를 할 수 있을 것이다’ 같이 언어와 전혀 상관이 없는 능력에 관해서도 사용자는 사진을 보여줬을 때 보다 높은 평가를 주었다. 이는 말하기, 턴테이킹을 보여주었을 때 로봇의 능력에 대한 부정확한 멘탈모델이 형성된다는 선행연구를 어느정도 뒷받침 한다.[10] 그렇기에 단순한 서빙을 하는 소셜 로봇을 설계할 때 언어적 표현의 상호작용은 조심스럽게 고려되어야 할 것이다. 이와 반대로 비언어적 상호작용을 했을 때 사용자가 느끼는 물리적 역량은 유의미한 차이를 보이지 못했다. 그림 4를 살펴보면 사진을 보여 줬을 때보다 물리적 역량에 대한 기대치가 전반적으로 낮은 것을 볼 수 있는데, 만약 실제 설계된 로봇의 기능이 적다면, 비언어적 상호작용을 통해 사용자의 기대 차이를 어느 정도 줄일 수 있을 것이다. 사회적 역량에 대한 기대치는 대화와 관련이 있기에 언어적 상호작용에서 높은 기대치를 형성할 것이라 예상했지만, 결과는 두 상호작용 모두 통계적으로 유의미하지 않게 나왔다. 이는 카페에서 일하는 소셜로봇의 사회적 역량에 대한 낮은 초기 기대치가 상호작용 이 후에도 지속된 것으로 보여진다.

Ⅵ. 결론

이 연구는 카페, 음식점 내 소셜로봇 도입이 얼마 남지 않은 상황에서 사용자가 느끼는 높은 초기 기대치와, 이를 극복하기 위한 적합한 상호작용 방식을 제안함에 의의가 있다. 그럼에도 불구하고 이 연구에는 한계점이 존재한다. 첫 번째는 아직 체험해보지 못한 사용자의 기대를 변인으로 잡았기 때문에, 실제 로봇의 기능과의 기대차이는 배제하고 실험을 진행했다. 만약 실제 로봇이 상용화 되고 그 기능이 분명히 정해졌다면 실존하는 소셜 로봇에 대해 사람들의 사전 기대와 상호작용 후 기대를 살펴볼 수 있을 것이다. 두 번째 한계점은 정적 이미지와 영상으로 실험을 진행하여 실험 참가자들과의 적극적인 인터랙션이 부족했다고 볼 수 있다. HRI 연구에서 비디오 실험과 실제 실험은 사용자 경험의 차이가 크지 않다는 연구가 있었지만 본 실험은 짧은 상호작용을 통해 인식의 변화를 측정했기에, 다른 연구에서 긴 상호작용으로 실험할 경우 인지된 역량이 달라질 수 있을 것이다. 세 번째 한계점은 사용자가 가지는 초기 기대치가 살아온 환경, 경험 등에 크게 영향을 받을 수 있다는 점이다. 본 실험에서는 설문을 통해 사전에 음료, 음식을 나르는 소셜로봇을 직접 경험하거나, 매체를 통해 경험한 참가자는 측정결과에서 제외하고 결과를 도출하는 작업을 통해 최대한 괴외변인의 효과를 통제하고자 하였지만, 그 외에도 다양한 변인의 영향을 받을 것이다. 마지막으로 연구 참가자들의 연령대가 20-30대에 치우쳐져 있어, 이미 공상과학 영화나 미디어를 통해 로봇을 많이 접했던 사용자들만을 대상으로 실험을 진행했다는 점이다. 로봇에 대한 직간접적인 경험이 부족한 다른 연령대의 참가자를 대상으로 실험한다면 다른 결과가 나타날 수도 있기 때문에 연령층을 확장해 실험을 진행할 필요가 있다.

이러한 한계점에도 불구하고 본 연구는 소셜 로봇이 사회에 도입될 때 반영할 수 있는 사용자들의 인식과 기대치에 대한 실험을 구체적인 상황을 토대로 진행했다는 점에서 의의가 있다. 추후에는 다양한 환경 맥락에서 다른 소셜 로봇에 대해서도 연구가 이루어질 필요가 있을 것이며 이런 연구를 통해 사용자의 기대와 실제 능력간의 차이를 줄일 수 있다면 기대차이가 극복되면서 소셜로봇이 조금 더 쉽게 일상생활에 수용될 것으로 기대된다.

References

- C. Breazeal, B. Scassellati, “A context-dependent attention system for a social robot,” rn, Vol. 255, No. 3, 1999

-

T. Fong, I. Nourbakhsh, and K. Dautenhahn, “A survey of socially interactive robots,” Robotics and autonomous systems, Vol.24, No.3-4, pp.143-166, 2003.

[https://doi.org/10.1016/S0921-8890(02)00372-X]

-

K. Jokinen, and G. Wilcock, “Expectations and first experience with a social robot,” in Proceedings of the 5th International Conference on Human Agent Interaction, Bielefeld, pp. 511-515, 2017.

[https://doi.org/10.1145/3125739.3132610]

-

J. Goetz, and S. Kiesler, “Cooperation with a robotic assistant,” in CHI'02 Extended Abstracts on Human Factors in Computing Systems, Minnesota, pp. 578-579, April 2002.

[https://doi.org/10.1145/506443.506492]

-

D. Anastasiou, K. Jokinen, and G. Wilcock, “Evaluation of WikiTalk-user studies of human-robot interaction,” In International Conference on Human- Computer Interaction, Berlin, Heidelberg, pp. 32-42, 2013.

[https://doi.org/10.1007/978-3-642-39330-3_4]

-

M. Lohse, “The role of expectations in HRI,” New Frontiers in Human-Robot Interaction, Bielefeld, pp. 35-56, 2009.

[https://doi.org/10.1075/ais.2.04loh]

-

T. Komatsu, R. Kurosawa, and S. Yamada, “How does the difference between users’ expectations and perceptions about a robotic agent affect their behavior?,” International Journal of Social Robotics, Vol. 4, No. 2, pp. 109-116, 2012.

[https://doi.org/10.1007/s12369-011-0122-y]

-

S. Paepcke, and L. Takayama, “Judging a bot by its cover: an experiment on expectation setting for personal robots,” In 2010 5th ACM/IEEE International Conference on Human-Robot Interaction (HRI), Osaka, pp. 45-52, March 2010.

[https://doi.org/10.1109/HRI.2010.5453268]

-

F. D. Davis, “Perceived usefulness, perceived ease of use, and user acceptance of information technology,” MIS quarterly, Vol. 13, No. 3, pp. 319-340, September 1989.

[https://doi.org/10.2307/249008]

-

M. Kwon, M. F. Jung, and R. A. Knepper, “Human expectations of social robots,” In 2016 11th ACM/IEEE International Conference on Human-Robot Interaction (HRI), New Zealand, pp. 463-464, March 2016.

[https://doi.org/10.1109/HRI.2016.7451807]

- T. Komatsu, and S. Yamada, “Adaptation gap hypothesis: How differences between users’ expected and perceived agent functions affect their subjective impression,” Journal of Systemics, Cybernetics and Informatics, Vol. 9, No. 1, pp. 67-74, 2011.

-

E. Weingarten, Q. Chen, M. McAdams, J. Yi, J. Hepler, and D. Albarracín, “From primed concepts to action: A meta-analysis of the behavioral effects of incidentally presented words,” Psychological Bulletin, Vol. 142, No. 5, pp. 472, 2016.

[https://doi.org/10.1037/bul0000030]

-

C. Edwards, A. Edwards, P. R.Spence, and D. Westerman, “Initial interaction expectations with robots: Testing the human-to-human interaction script,” Communication Studies, Vol. 67, No. 2, pp. 227-238, 2016.

[https://doi.org/10.1080/10510974.2015.1121899]

- D. J. Rea, and J. E. Young, “It's All in Your Head: Using Priming to Shape an Operator's Perceptions and Behavior during Teleoperation,” In Proceedings of the 2018 ACM/IEEE International Conference on Human-Robot Interaction, Chicago, pp. 32-40, February 2018.

-

A. Edwards, C. Edwards, D. Westerman, and P. R. Spence, “Initial expectations, interactions, and beyond with social robots,” Computers in Human Behavior, Vol. 90, pp. 308-314, 2019.

[https://doi.org/10.1016/j.chb.2018.08.042]

- P. N. Johnson-Laird, Mental models: Towards a cognitive science of language, inference, and consciousness (No. 6), Harvard University Press, 1983.

-

B. Seppelt, and T. Victor, Driver’s mental model of vehicle automation. Handbook of Human Factors for Automated, Connected, and Intelligent Vehicles, 55-66, 2020.

[https://doi.org/10.1201/b21974-3]

- J. D. Lee, and K. A. See, “Trust in automation: Designing for appropriate reliance,” Human factors, Vol. 46, No. 1, 50-80, 2004.

-

R. D. Dewar, and J. E. Dutton, “The adoption of radical and incremental innovations: An empirical analysis,” Management science, Vol. 32, No. 11, pp. 1422-1433, 1986.

[https://doi.org/10.1287/mnsc.32.11.1422]

-

F. D. Davis, “User acceptance of information technology: system characteristics, user perceptions and behavioral impacts,” International journal of man-machine studies, Vol. 38, No. 3, pp. 475-487, 1993.

[https://doi.org/10.1006/imms.1993.1022]

- J. M. Beer, A. Prakash, T. L. Mitzner, and W. A. Rogers, Understanding robot acceptance, Georgia Institute of Technology, Atlanta, Technical Report HFA-TR-1103, 2011.

- B. Reeves, and C. I. Nass, The media equation: How people treat computers, television, and new media like real people and places, Cambridge University Press, 1996.

-

E. Cha, A. D. Dragan, and S. S. Srinivasa, “Perceived robot capability,” In 2015 24th IEEE International Symposium on Robot and Human Interactive Communication (RO-MAN), Kobe, pp. 541-548, 2015.

[https://doi.org/10.1109/ROMAN.2015.7333656]

- H. Kikuchi, M. Yokoyama, K. Hoashi, Y. Hidaki, T. Kobayashi, and K. Shirai, “Controlling gaze of humanoid in communication with human,” In Proceedings of the 1998 IEEE/RSJ International Conference on Intelligent Robots and Systems, Victoria, pp. 255-260, October 1998.

-

A. M. Rosenthal-von der Pütten, N. C. Krämer, and J. Herrmann, “The effects of humanlike and robot- specific affective nonverbal behavior on perception, emotion, and behavior,” International Journal of Social Robotics, Vol. 10, No. 5, pp. 569-582, 2018.

[https://doi.org/10.1007/s12369-018-0466-7]

-

M. Desai, M. Medvedev, M. V´azquez, S. McSheehy, S. GadeaOmelchenko, C. Bruggeman, A. Steinfeld, and H. Yanco, “Effects of changing reliability on trust of robot systems,” in 2012 7th ACM/IEEE International Conference on Human Robot Interaction, Boston, pp. 73–80, 2012

[https://doi.org/10.1145/2157689.2157702]

-

C. Ray, F. Mondada, and R. Siegwart, “What do people expect from robots?” in 2008 IEEE/RSJ International Conference on. Intelligent RObots and Systems, Nice, pp. 3816–3821.2018

[https://doi.org/10.1109/IROS.2008.4650714]

-

S. N. Woods, M. L. Walters, K. L. Koay, and K. Dautenhahn, “Methodological issues in HRI: A comparison of live and video-based methods in robot to human approach direction trials,”. In ROMAN 2006-the 15th IEEE international symposium on robot and human interactive communication, North Carolina, pp. 51-58, 2006.

[https://doi.org/10.1109/ROMAN.2006.314394]

저자소개

2019년 : 홍익대학교 (전자전기공학학사)

2019년~현 재: 연세대학교 정보대학원 UX 트랙 석사과정

※관심분야: HRI(Human-Robot Interaction), AI(Artificial Intelligence) 등

2020년 : 한양대학교(ERICA) (건축공학학사)

2020년~현 재: 연세대학교 정보대학원 UX 트랙 석사과정

※관심분야: UX 디자인(UX Design), AI(Artificial Intelligence), 자율주행(Autonomous Driving) 등

2012년 : 부산대학교 (문학학사)

2014년 : 부산대학교 대학원 (문학석사)

2021년 : 연세대학교 대학원(철학박사)

2018년 3월~2018년 8월 : 연세대학교 심리학과 강사

2018년~현 재: 연세대학교 정보대학원 강사

※관심분야: 인간공학(Human Factors), 자율주행(Autonomous Driving), UX디자인(UX Design) 등