에지 보정을 이용한 ORB SLAM2의 특징점 정합률 개선

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

이미지 인식에 대한 연구의 한 분야로, 물체를 인식하거나 분석할 때 주요 특징점을 추출하고 이미지 간의 정합을 하는 방법이 사용되고 있다. 여기에 사용되는 특징점 추출 알고리즘에는 SIFT, SURF, ORB가 있으며, 그 중 ORB는 주변 공간을 인식하고 분석하여 지도를 생성하고 위치를 추정하는 비쥬얼 SLAM 기술과 함께 자율 주행 기술에 사용된다. 자율 주행의 경우 운전자의 안전은 차량 간 사고 발생과 밀접한 관계가 있기 때문에 이미지 인식 기술이 매우 중요하므로, 보다 빠른 분석과 정확한 처리를 기반으로 위치 추정이 이루어져야 한다. 본 연구에서는 이러한 문제를 해결하기 위하여 이미지 보정을 통해 입력 이미지에서 많은 특징점을 추출할 수 있게 하며, 키 프레임 생성 조건을 수정하여 새로운 키를 생성하도록 하여, 위치 추정 및 정합 실패율을 줄이는 방법을 제안한다. 실험 결과로 정합률이 43% 향상되었고, 새로운 키 프레임 수도 증가하였다.

Abstract

As a field of research on image recognition, a method of extracting key feature points and matching between images is used when recognizing or analyzing objects. Feature point extraction algorithms used here include SIFT, SURF, and ORB. ORB is used in autonomous driving technology along with visual SLAM technology that generates a map and estimates the location by recognizing and analyzing the surrounding space. In the case of autonomous driving, since the driver's safety is closely related to the occurrence of accidents between vehicles, image recognition technology is very important, so position estimation should be made based on faster analysis and accurate processing. In our study, to solve the problem, we propose a method to extract many feature points from the input image through image correction and to generate a new key by modifying the key frame generation condition, thereby reducing the position estimation and matching failure rate. As a result of the experiment, the matching rate improved by 43% and the number of new key frames increased.

Keywords:

Key Point, SLAM, ORB SLAM, Edge Correction, Key Frame키워드:

특징점, SLAM, ORB SLAM, 에지 보정, 키 프레임Ⅰ. 서 론

4차산업 혁명 시대가 도래함에 따라 다양한 기술들이 발전하고 있는 가운데 컴퓨터 비전 분야에서는 영상 인식에 대한 연구가 활발히 진행되고 있다[1]. 영상에서 사물을 인식하거나 분석할 때 일반적으로 이미지로부터 주요 특징점을 추출하여 영상 간 정합하는 방법을 사용한다. 특징점 추출 방법은 이미지의 특징을 추출해주는 검출자(detector)와 추출된 특징의 정보를 표현해주는 기술자(descriptor)로 나뉜다. 검출자에 의해 추출된 특징점(key point)은 해당 이미지에서의 특징을 나타내고 있는 부분이므로 카메라의 위치, 회전, 크기 변화, 조명 등에도 쉽게 식별 가능해야 한다. 이런 특징점을 검출하는 알고리즘은 여러 종류가 있으며 추출 방법에 따라 나뉜다.

픽셀의 기울기 값을 계산하여 코너를 검출하는 Harris corner[2], Scale space를 이용하여 특징점을 추출하는 SIFT(Scale Invariant Feature Transform)[3], 조명, 시점 등의 변화에 불변하는 특징점을 추출하는 SURF(Speed Up Robust Features)[4], 픽셀 P와 주변 픽셀에 임계값을 적용하여 어두운 픽셀, 밝은 픽셀, 유사한 픽셀로 분류하여 원 위의 픽셀이 연속적으로 어둡거나 밝아야 하는 조건을 계산하여 특징점을 검출하는 FAST(Feature from Accelerated Segment Test)가 있다.

추출된 특징점 간의 비교를 해주는 기술자의 경우 회전 변화와 크기 변환에 대해 불변하는 SIFT, 기울기를 방향에 따라 히스토그램에 영역에 표현한 HOG(Histogram of Oriented Gradient), 이미지 패치 내의 일부 픽셀 쌍의 값의 비교만으로 생성되는 BRIEF, FAST로 특징점을 구하여 픽셀의 밝기 값의 분포를 고려하여 코너 방향을 계산한 다음 이 방향으로 BRIEF에 필요한 점들의 위치를 보정하여 회전에 불변하는 BRIEF 기술자를 계산하는 ORB가 있다. ORB의 경우 SIFT와 동일하게 검출과 기술을 동시에 지원하며 빠른 비교와 높은 구별성을 갖는다[5].

이러한 ORB는 센서를 통하여 주변 공간을 인식하고 이를 분석하여 지도 생성 및 위치를 추정하는 비주얼 SLAM(Simultaneous Localization and Mapping)의 기술과 접목하여 자율주행 기술에 사용된다[6]. 현재 자율주행 기술은 차선 이탈 방지, 차량간격 유지와 같은 운전자의 주행을 보조하는 정도의 역할로 부분 자율주행 기술이 자동차에 적용되고 있으며 완전 자율 주행의 경우 운전자의 안전과 차량 간의 사고 발생에 밀접한 관계가 있어 영상 인식 처리 기술이 매우 중요하다[7]. 하지만 SLAM은 영상 내의 특징을 이용하여 현재 위치를 파악하여 지도를 생성하기 때문에 현재 위치와 이전 위치의 변화에 차이가 크게 되면 많은 특징점을 추출하지 못하는 경우 서로 공통된 지점이 적어짐에 따라 정확한 위치를 제공하지 못하게 된다[8]. 이러한 문제점은 큰 사고로 이어질 수 있으며 이는 곧 자율주행에 있어 큰 단점이 된다. 반복적인 구조와 환경 변화의 차이가 큰 곳에서 위치 추정실패의 경우를 줄이기 위하여 이를 보정해 줄 수 있는 알고리즘이 필요하다. 본 논문에서는 입력된 이미지에 선명화 필터를 적용하여 이미지를 보정하고 새로운 키프레임을 생성하기 위한 키프레임 생성 조건을 수정하여 위치 추정 및 정합 실패율을 줄이는 방법을 제안한다.

Ⅱ. 기존의 연구 방법

2-1 ORB SLAM

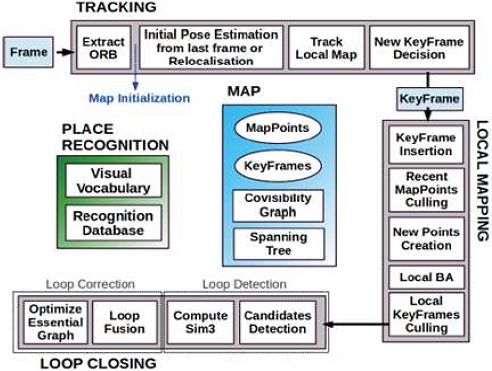

ORB(Oriented FAST and Rotated BRIEF) SLAM은 Raul Mur-Artal 외 2명이 제안한 기술로써 ORB SLAM2의 기반이 되는 시스템이며 단안 카메라를 사용한다[9]. 반면 ORB SLAM2는 단안 카메라뿐만 아니라 스테레오, RGB-D 카메라를 사용 실시간으로 사물을 인식하고 정밀한 지도를 생성하는 자율 주행 기술에 사용되고 있는 알고리즘이다[10]. ORB SLAM은 그림 1과 같이 3개의 쓰레드가 병렬로 구성되어 있으며 각 쓰레드는 Tracking, Local mapping, Loop closing으로 나뉜다[11].

Tracking이란 인접한 프레임 사이에는 크기와 위치 같은 정보들의 유사성이 존재하며 이를 이용하여 위치 변화를 추적하는 것을 의미한다. Tracking 쓰레드는 입력된 영상으로부터 ORB 알고리즘을 이용하여 특징점을 추출하는 것을 시작으로 FAST라는 특징 추출 방법을 이용하여 입력 영상에서 코너를 찾은 다음 BRIEF라는 기술자를 사용하여 영상의 특징점을 추출하는 과정을 수행한다. 그 다음 카메라 위치 조정 단계로 넘어가며 추적이 잘되는 경우와 그렇지 않은 경우로 나뉘게 된다. 추적이 잘되는 경우 이전 프레임을 이용하여 현재 프레임의 카메라 위치를 추정하게 되며 트래킹에 실패할 경우 Place Recognition 모듈의 BoW(Bag of Words)를 활용하여 현재 영상과 가장 유사한 키프레임 위치를 찾아내어 다시 트래킹하는 global relocalization을 수행한다. 이후 기존의 작성된 지도와 키프레임의 맵 포인트(지도정보)를 추가적으로 투영시켜 일치하는 항목을 검색하여 보다 정확한 카메라 위치를 최적화한 뒤 새로운 프레임이 있는지 확인한다. 새로운 프레임이 생성되기 위해서는 4가지의 조건이 있다.

- ① 마지막 global relocalization으로부터 20프레임 이후여야 한다.

- ② local mapping이 적합하거나 마지막 키프레임 삽입이 20프레임 이후여야 한다.

- ③ 현재 프레임은 적어도 50개의 특징점이 있어야 한다.

- ④ 현재 프레임에서 참고하고 있는 키프레임의 특징점은 90% 이내여야 한다.

위의 4가지 조건을 만족하지 않을 경우 프레임이 생성되지 않는다.

Local mapping에서는 새롭게 생성된 키프레임에 대하여 BoW를 수행하고 이를 바탕으로 새로운 키프레임과 이전 프레임의 맵 포인트를 비교한 후 겹쳐지는 점들을 따로 모아 두는 동시성(covisibillity) 그래프를 수정하는 과정을 반복한다. 맵 포인트 개수를 최적화하기 위하여 각 키프레임을 비교하여 시계(visibility)가 떨어지거나 트래킹이 이루어지지 않는 맵 포인트를 제거하는 로컬 BA(Bundle Adjustment)과정을 거친다. 이때 생성된 모든 키프레임은 3개 이상의 다른 키프레임의 맵 포인트들과 90%이상 동시성 조건을 만족하여야 한다. 이런 과정을 통해 키프레임을 자유롭게 삽입한 후 중복되는 것을 확인하고 삭제하는 과정을 반복하여 동시성 그래프의 크기가 무한대로 커지는 것을 방지한다.

마지막으로 Loop closing 쓰레드에서는 이전에 방문한 적이 있는 위치인지 확인하고 방문했던 위치라고 판단되면 Loop closing이 발생하여 이전에 생성된 지도와 통합한다. 또한 영상 추출과 분석 단계에서의 오류가 조금씩 누적되면 현재의 위치를 방문했던 적은 있지만 다른 위치로 판단하여 지도 생성 시 오차가 발생한다. 이처럼 오차가 발생하였을 경우 위치 인식 모듈을 통하여 동시성 그래프와 키프레임 간의 유사성을 살펴보고 새 키프레임에 대해 Loop closing이 시도되도록 작업을 수행한다. 이때 유사성 점수는 키프레임의 BoW를 이용하여 계산이 되며 유사성 점수가 높은 경우 Loop closing의 후보가 된다. 연결된 후보가 3개가 될 때 Loop closing이 발생한다. 그 이후 동시성 그래프가 업데이트 된다.

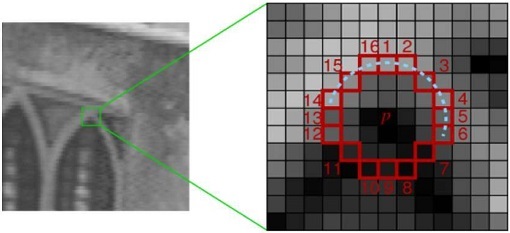

2-2 ORB 추출

ORB 알고리즘은 FAST 검출기와 BRIEF 기술자를 사용하여 특징점을 찾는 알고리즘이다[12]. FAST는 그림 2와 같이 중심 픽셀 p가 코너인지 확인하기 위하여 픽셀 p를 중심으로 반지름 3인 원의 가장자리에 있는 16개 픽셀과 중심 픽셀 p의 값을 비교한다. p보다 일정값(Ⅰp+t) 이상 밝은 픽셀이 n개 이상 연속되거나 일정값 (Ⅰp-t) 이하 어두운 픽셀들이 n개 이상 연속되어 있으면 p를 코너점으로 판단하여 특징점으로 사용하게 된다. 또한 빠른 특징점 추출을 위하여 1, 5, 9, 13번 픽셀의 값이 식(1)의 조건을 만족하는지 검사하여 최소 3개의 픽셀이 해당되면 나머지 12개 픽셀에 대해서도 수행한다. 하지만 입력된 영상이 흔들림이 심하거나 단조로운 영상의 경우 중심 p 픽셀과 가장자리의 차이가 없게 되어 특징점으로 추출하는데 어려움이 발생한다.

| (1) |

Ⅰp : p의 회색값, t : 임계값

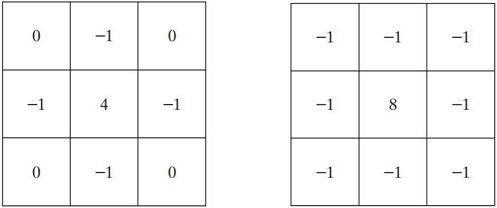

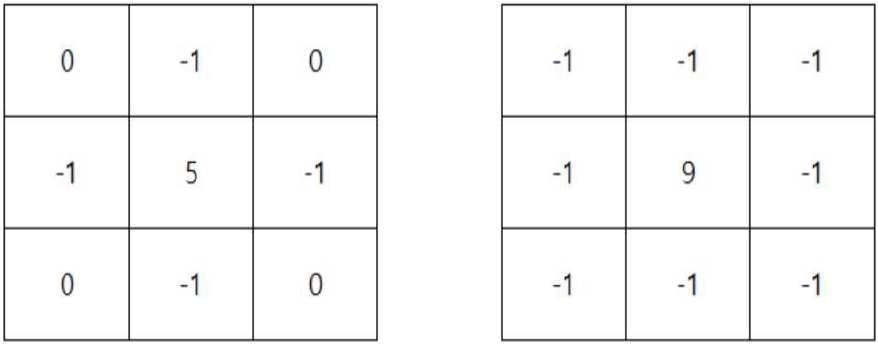

2-3 선명화 필터

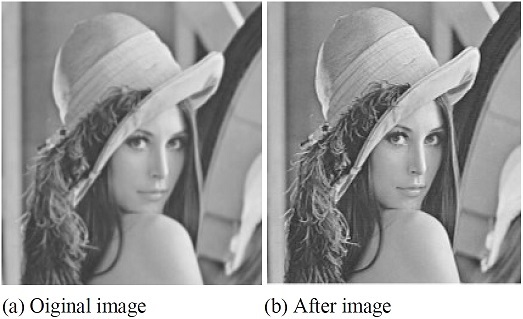

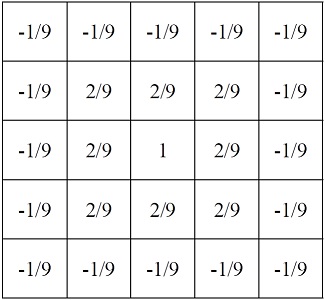

선명화 필터는 영상을 선명하게 하거나 에지를 검출하는데 사용하는 방법으로 마스크 계수에 따라 결과값이 달라진다. 선명화 필터는 그림 3의 라플라시안 마스크를 기본으로 하고 있으며 대표적인 2차 미분 연산자로 모든 방향의 에지를 강조한다. 마스크 배열 요소의 전체 합은 0이 되며 마스크를 영상에 적용하였을 때 픽셀 값이 일정한 곳에서는 결과 값이 0, 픽셀 값의 차가 큰 곳이라면 결과 값이 커지게 된다[13]. 그림 4는 라플라시안 마스크를 적용하여 에지를 출력한 결과 영상이다. 하지만 전체의 요소의 합이 0이 될 경우 해당 픽셀의 정보를 표현 할 수 없으므로 영상을 더욱 선명하게 만들기 위해서는 해당 영역의 픽셀값이 보존되어야 한다[14]. 그림 5는 선명화 마스크를 의미하며 선명화 마스크의 배열 요소의 합이 1이 되도록 라플라시안 마스크 중앙값에 1을 더하여 사용한다. 그림 5는 선명화 마스크를 적용한 결과 영상으로 원본 영상(a)보다 선명한 영상(b)을 결과 값으로 얻는다.

Ⅲ. 개선된 특징점 추출을 위한 조건부 전처리

기존의 ORB SLAM2에서는 입력된 영상에서 ORB의 FAST 검출자를 이용하여 특징점을 추출한다. 흔들림이 심하거나 환경 변화의 차이가 큰 영상에서는 현재 프레임과 마지막 키프레임 사이에서 공유되는 충분한 특징점의 개수가 적어 추적 실패(track lost)의 문제가 발생한다. 이러한 문제점을 해결하기 위하여 현재 프레임과 키프레임 사이의 공통된 특징점이 많도록 입력된 영상에 전처리를 하여 특징점의 개수를 늘려주는 방법과 현재 프레임과 키프레임 사이에 연속성을 유지하기 위하여 새로운 키프레임을 추가하는 방법을 제안한다. 추적 실패는 마지막 키프레임과 현재 프레임 사이에 정합된 특징점 수가 30개 미만일 때 발생하므로 추적 실패가 발생하는 또 다른 조건인 새로운 키프레임 생성시 특징점이 90% 이내여야 한다는 조건보다는 특징점의 개수가 많아야 한다. 이를 위해 정합된 특징점의 개수가 최소값을 보일 때의 분포를 확인함으로써 추적 실패의 발생빈도 수를 확인한다.

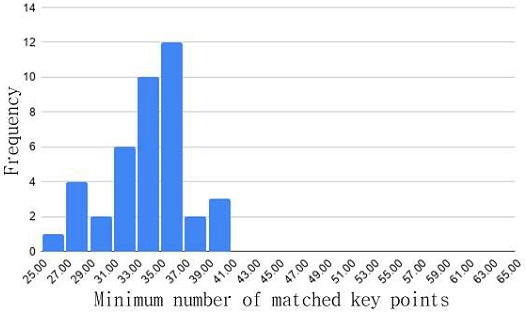

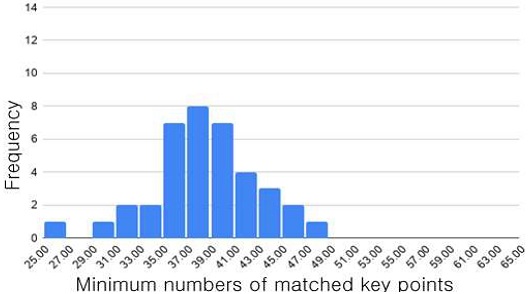

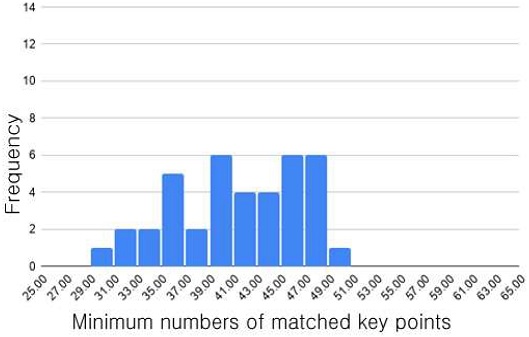

그림 7은 동일한 영상을 ORB SLAM2으로 40번 실행하여 정합된 특징점 개수의 최소값을 히스토그램으로 나타낸 것이다. 평균 정합 개수는 33.4개이며 발생 빈도가 평균 주위에 많이 분포되어 있는 것을 확인할 수 있으며 그래프를 통하여 특징점의 최소값이 30개 미만인 경우가 다소 발생하여 추적 실패가 발생하였다는 것을 확인할 수 있다. 본 연구에서 제안하는 방법은 정합된 특징점 개수의 최소값을 높여주기 위하여 현재 프레임과 이전 키프레임 사이의 정합 개수가 줄어들 때 새로운 키프레임 삽입 조건을 완화하고 선명회 필터 기법을 적용하여 입력된 영상의 정보가 극대화 될 수 있게 함으로써 추적 실패의 발생 빈도를 줄이고자 한다.

3-1 선명화를 이용한 입력 영상 전처리

다음과 같이 실시간으로 입력되는 영상의 정보가 두드러져 많은 특징점을 추출할 수 있도록 ORB SLAM2에 전처리 모듈을 추가한다.

if key points of current image

< 0.9 * maximum key points then

Execute the preprocessing to sharpen the image

end

현재 프레임에서 추출된 특징점의 개수가 한 영상에서 최대 특징점 추출 개수의 90% 이하가 될 때 전처리 모듈을 실행하여 특징점의 개수를 늘리도록 한다. 마스크를 입력 영상의 픽셀에 위치하여 각 입력 픽셀 값과 대응되는 마스크 요소 값을 곱하여 그 결과 값을 모두 더한다. 마스크가 적용된 중앙 픽셀이 결과값을 가지며 모든 픽셀에 대하여 반복 수행한다. 3x3의 경우 결과값의 차이가 없어 5x5 크기의 마스크를 사용한다. 마스크의 중심은 양의 큰 값을 가지며 주변의 요소는 음의 작은 값을 지닌다. 해당 마스크로 컨볼루션 연산을 수행하는 경우 중심 픽셀과 주변 이웃픽셀 값이 차이가 커지게 되므로 입력 영상의 경계선은 더 날카로워져 선명한 영상이 된다.

3-2 새로운 키프레임 삽입

하나의 키 프레임 생성 이후 새로운 키프레임을 생성하기 위해서는 4가지 조건을 만족해야 한다. 그 중 가장 엄격한 조건은 현재 프레임이 마지막 키프레임으로부터 일정 간격만큼 떨어져 있을 때 새로운 키프레임의 삽입 여부를 판단하는 것이다. 카메라가 이동하거나 회전할 때 환경변화가 클 경우 키프레임의 수가 늘어난다. 하지만 이동 및 회전속도가 너무 빨라 새로운 키프레임 생성 조건인 20프레임을 만족하지 못할 경우 새로운 키 프레임이 생성되지 않아 추적 실패가 발생하게 된다. 다음은 추적 실패를 줄이기 위해 새로운 키프레임 삽입 조건을 다소 완화시켜 사용하는 알고리즘이다.

if key points of current image

< 0.90 X reference key points then

Maximum number of frames is 1

end

새로운 키 프레임을 생성하기 위해서 현재 프레임에서 참고하고 있는 키프레임의 특징점은 최대 90% 이내여야 한다는 조건이 있다. 특징점의 개수가 90% 이하로 떨어질 경우 20개의 프레임 이후에 새로운 키 프레임을 생성되는 조건을 1개의 프레임 이후로 변경하여 사용한다.

3-3 변경된 제안 알고리즘

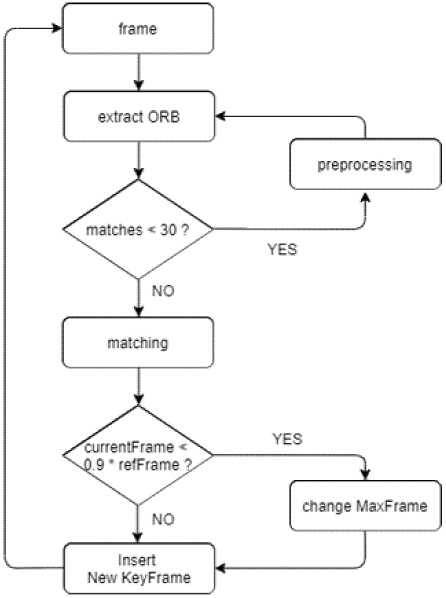

다음은 추적 실패가 발생하지 않기 위해 제안한 추적 알고리즘이며, 입력 영상의 전처리와 새로운 키프레임의 삽입 조건도 포함된다. 그림 10은 간략화한 흐름도이다.

(1) 입력장치로부터 영상이 입력된다.

(2) ORB를 이용하여 특징점을 추출하고 특징점이 풍부한 프레임을 키프레임으로 선정하는 작업을 반복한다.

(3) 입력된 현재 프레임과 이전에 생성된 키프레임 사이에 공유되는 특징점의 개수가 30개 미만인지 판단한다.

(4) 이때 정합된 특징점의 개수가 30개 미만일 경우 선명화 마스크를 이용하여 현재 프레임을 전처리한다.

(5) 정합된 특징점의 개수가 30개 이상일 때 정합 작업을 계속하게 된다.

(6) 새로운 키프레임이 생성되기 위해서는 20개의 연속된 프레임이 필요하다. 하지만 연속된 프레임 중에 추출되는 특징점의 개수가 이전 키프레임 특징점의 90%만 참고하고 있다면 추적 실패의 가능성이 있기에 새로운 키프레임 생성 조건인 20개의 연속된 프레임 개수를 1개의 프레임으로 변경하여 새로운 키프레임을 생성한다.

(7) 새로운 키프레임이 생성되면 (1)부터 다시 반복하여 수행한다.

Ⅳ. 실험 및 평가

4-1 실험 방법

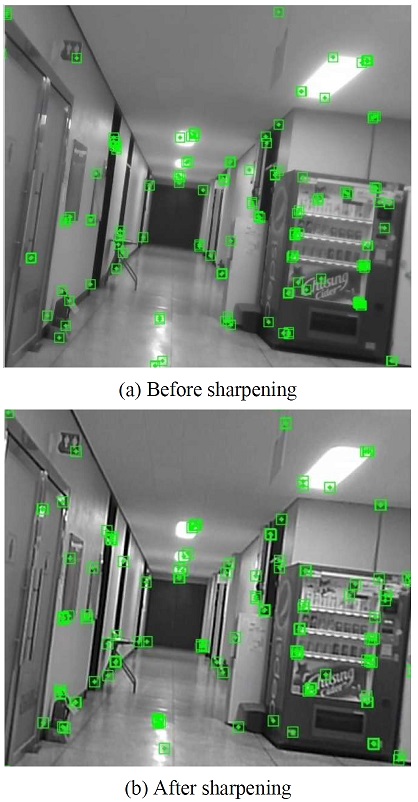

제안한 방법의 실험을 위하여 학교 내부의 환경 변화의 차이가 큰 복도 부분을 빠르게 회전하여 추적 실패가 발생하는 영상을 제작하고 실험하였으며 기존의 방법과 제안하는 방법으로 실험하여 얻어진 결과값을 비교 및 평가하였다. 영상에서 추출하는 특징점의 최대 개수는 500개로 제한하였으며 빈도수를 통한 결과값을 얻기 위하여 영상을 40번 반복하여 수행하였다. 본 실험은 Ubuntu 16.04 운영체제, 8기가 메모리, Intel RealSense Depth Camera D435i를 사용하였다.

4-2 성능 평가 및 결과

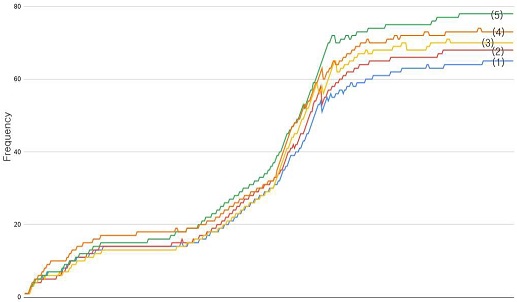

실험은 정합된 특징점 개수의 최소값 분포를 추적 성공률의 평가지표로 정하고 기존의 방법과 제안한 방법에 전처리 모듈만 적용한 경우, 새로운 키프레임 생성 조건을 변경하는 방법만 적용한 경우, 두 가지 방법을 모두 적용하여 영상이 입력될 경우, 무조건 전처리 후에 조건에 따라 새로운 키프레임을 생성하는 조건을 변경하는 경우, 두 방법 모두 조건에 따라 수행하는 경우를 각각 나누어 실험하여 도출된 결과값을 비교하였다. 표 1에는 기존의 방법으로 수행한 정합 개수의 평균값은 33.4이고, 제안한 방법으로 수행하였을 때의 정합 개수의 평균값은 47.83으로 43% 성능이 향상된 것을 알 수 있다.

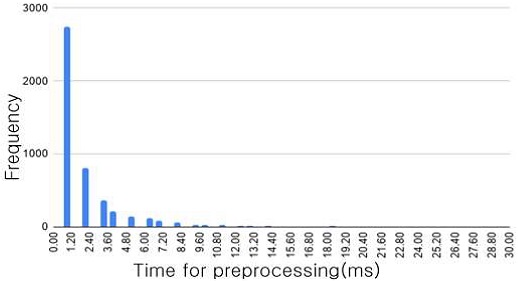

그림 11은 입력된 영상을 전처리를 했을 때 발생하는 수행시간으로 하나의 영상을 처리하는데 걸리는 시간은 평균 2.593ms이고 중간값은 2.192ms이다. 하나의 프레임을 처리하는데 걸리는 시간은 얼마 되지 않지만 모든 영상에 대해 전처리할 경우 처리량의 증가로 일부 영상에 대해서 추적을 하지 못하는 경우가 발생한다.

그림 12는 입력된 영상이 전처리 모듈을 거쳐 선명화를 했을 때 정합된 특징점 수의 최소값을 나타낸 것이며 평균은 37.65이다. 기존의 ORB SLAM2에 비해 평균값은 증가하였지만 기존보다 넓은 분포를 가지기 때문에 여전히 추적 실패가 발생한다. 하지만 추적 실패의 발생 빈도는 다소 줄어든 것을 확인할 수가 있다.

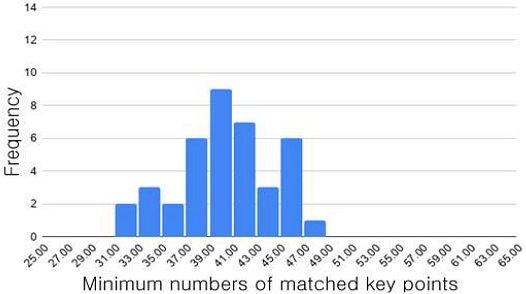

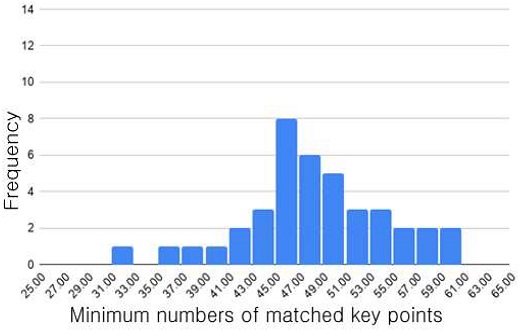

그림 13은 영상에 대한 전처리 없이 특징점이 희소해지는 경우를 판별하여 새로운 키프레임을 삽입할 수 있도록 조건을 완화시킨 후 정합된 특징점 개수의 최소값의 분포를 나타낸다. 평균값은 39.83으로 선명화만 적용하였을 때보다 다소 높아진 것을 확인할 수가 있으며 추적 실패 발생 기준에서도 약간 벗어남을 알 수가 있다. 하지만 여전히 발생 가능성이 존재한다.

그림 14는 입력된 모든 영상에 전처리를 수행한 후 추출되는 특징점의 개수에 따라 조건부 새로운 키프레임 생성 조건을 적용하였다. 평균값은 41.05이고 기존의 방법보다는 특징점 추출 개수의 최소값이 높아졌지만 평균값 중심으로 넓게 분포하고 있어 여전히 추적 실패의 가능성이 남아있다. 또한 조건에 따른 새 키프레임 삽입 때보다 추적 실패의 빈도가 더 많은 것을 알 수 있다.

그림 15는 추가한 전처리 모듈에 입력된 영상에 대해 정합의 개수가 부족해질 경우 선명화하고 더불어 특징점의 개수가 떨어질 때 새로운 키 프레임 삽입 조건을 완화하고 적용한 결과값을 나타낸다. 평균값은 47.83으로 다른 방법들에 비해 평균값이 가장 높아 추적 실패 발생 기준에서도 멀리 떨어진 것을 확인할 수가 있다. 선명화를 적용하여 분포가 넓게 퍼져 있지만 평균값과의 차이가 커서 추적 실패가 발생하지 않았다. 조건부에 따른 전처리 모듈과 새 키프레임 삽입 방식 모두 전체 구간에서 정합된 특징점의 개수가 비슷하게 나타났으며 ORB SLAM2의 성능을 떨어트리는 일 없이 특징이 희소한 환경에서도 추적 실패를 발생시키지 않고 수행하였다.

Histogram of minimum numbers of matched key points with preprocessing according to condition and changing condition

그림 16은 기존의 방법을 기준으로 하여 전처리 모듈을 적용하였을 때, 새 키프레임 생성 조건을 변경하였을 때, 모든 입력영상 전처리 후 조건 변경하였을 때, 조건부 전처리 후 조건 변경하였을 때, 새로운 키프레임 증가율을 나타낸다. 모든 입력 영상을 전처리한 경우에서 키프레임이 증가한 이유는 기존의 정합되지 않았던 특징점이 선명해짐에 따라 새로운 키프레임 수가 증가하였으며 그 외 3가지 방법의 경우는 정합을 위한 충분한 특징점의 추출을 위해 새로운 키프레임 수가 증가하였다.

Ⅴ. 결 론

ORB SLAM은 실시간으로 사물을 인식하고 정밀한 지도를 생성하는 자율주행 기술에 사용되며 위치 추정이 제대로 이루어지지 않을 경우 운전자와 차량간의 대형사고로 이어질 수 있기 때문에 보다 빠른 분석과 정확한 처리를 기반으로 위치 추정이 이루어져야 한다. 이에 제안 연구에서는 기존의 ORB SLAM을 수행하였을 때 연속된 영상 간의 환경적 변화의 차이가 클 경우 충분한 특징점을 추출하지 못하여 추적을 하기 위한 새로운 키프레임을 생성하지 못하여 추적 실패의 문제가 발생하였다. 이러한 문제를 해결하기 위하여 전처리 모듈을 추가하여 입력된 영상을 선명화 처리하였으며 영상간의 충분한 특징점을 공유할 수 있도록 두 영상의 간극을 좁히는 새로운 키프레임을 삽입하는 조건을 적용하였다. 그 결과 기존의 방법으로 수행하였을 때 정합되는 최소값의 평균값은 33.4개였으며 제안한 방법으로 수행하였을 때의 결과값은 47.83으로 나타나 기존 대비 성능이 43% 향상된 것을 확인하였다. 본 실험을 통하여 기존에 발생하였던 추적 실패의 비율보다 제안한 방법이 추적 실패의 발생 비율을 현저히 줄였으며 빠른 환경 변화의 차이에도 원활히 추적되는 것을 확인할 수 있었다. 하지만 실내라는 제한적인 장소에서 실험을 하였기 때문에 실외에서 수행하게 될 경우 또 다른 문제점이 발생할 수 있을 것이라고 예상해 본다. 향후 연구에서는 제안한 방법을 이용하여 학교 실내와 같은 제한된 환경 내에서가 아닌 더 넓은 실외 환경에서도 실행해보고 발생하는 문제점에 대해 해결하는 방법에 대한 연구를 수행해야 할 것으로 보인다.

References

-

R. Okuda, Y. Kajiwara, and K. Terashima, “A Survey of Technical Trend of ADAS and Autonomous Driving”, Proc. of Technical Program-2014 Int. Symposium on. IEEE, pp. 1-4, 2014.

[https://doi.org/10.1109/VLSI-TSA.2014.6839646]

-

C. Harris and M. Stephens, “A Combined Corner and Edge Detector”, In Alvey Vision Confernce, pp. 147-151, 1988.

[https://doi.org/10.5244/C.2.23]

-

Lowe, David G., "Distinctive Image Features from Scale-Invariant Keypoints", International journal of computer vision, Vol. 60, No. 2, pp. 91-110, 2004.

[https://doi.org/10.1023/B:VISI.0000029664.99615.94]

-

Bay, Herbert, et al., "Speeded-up Robust Features (SURF)", Computer vision and image understanding, Vol. 110, No. 3, pp. 346-359, 2008.

[https://doi.org/10.1016/j.cviu.2007.09.014]

-

E. Rosten and T. Drummond, “Machine Larning for Highspeed Corner Detection”, Proceedings of the European Conference on Computer Vision, pp. 430–443, 2006.

[https://doi.org/10.1007/11744023_34]

- T. Wu and A. Ranganathan, “Vehicle Localization using Road Markings”, IEEE Intell. Veh. Symp., pp. 1185-1190, 2013.

- T. Griggs and D. Wakabayashi, “How a Self-Driving Uber Killed a Pedestrian”, in Arizona, Retrieved, Mar., 21, 2018.

-

Yongjin Ock, Hosun Kang and Jangmyung Lee, “Modified ORB-SLAM Algorithm for Precise Indoor Navigation of a Mobile Robot”, Journal of Korea Robotics Society, Vol. 15, No. 3, pp. 205-211, 2020.

[https://doi.org/10.7746/jkros.2020.15.3.205]

-

Raul Mur-Artal and J. M. M. Montiel, “ORB-SLAM: a Versatile and Accurate Monocular SLAM System”,́ IEEE Transcations on Robotics, Vol. 31, No. 5, pp. 1147–1163, 2015.

[https://doi.org/10.1109/TRO.2015.2463671]

-

R. Mur-Artal and J. D. Tardos, “ORB-SLAM2: an Open-source SLAM System for Monocular, Stereo, and RGB-D Cameras”, IEEE Transactions on Robotics, Vol. 33, No. 5, pp. 1255–1262, 2017.

[https://doi.org/10.1109/TRO.2017.2705103]

- M. Andersson and M. Baerveldt, “Simultaneous Localization and Mapping for Vehicles using ORB-SLAM2”, Chalmers Univ. of Technology, Gothenburg, Sweden, 2018.

-

Ethan Rublee, Vincent Rabaud, Kurt Konolige and Gary Bradski, “ORB: an Efficient Alternative to SIFT or SURF”, IEEE International Conference on Computer Vision, 2011.

[https://doi.org/10.1109/ICCV.2011.6126544]

-

Sung-Un Kim, “An Image Denoising Algorithm for the Mobile Phone Cameras”, The Journal of the Korea institute of electronic communication sciences, Vol. 9, No .5, pp. 601-608, 2014.

[https://doi.org/10.13067/JKIECS.201.9.5.601]

-

A. Foi, V. Katkovnik and K. Egiazarian, “Pointwise Shape Adaptive DCT for High-quality Denoising and Deblocking of Grayscale and Color Images”, IEEE Transactions on Image Processing, Vol. 16, No. 5, pp. 1395–1411, 2007.

[https://doi.org/10.1109/TIP.2007.891788]

저자소개

2009년 : 경상대학교 컴퓨터과학과(공학사)

2018년~현재 : 경상대학교 대학원 컴퓨터과학과 석사과정 재학

※관심분야:머신 러닝, SLAM, 영상 인식

2010년 : 경북대학교 컴퓨터학부(공학사)

2012년 : 한국과학기술원(공학석사)

2017년 : 한국과학기술원(공학박사)

2018년~현재 : 경상대학교 컴퓨터과학과 조교수

관심분야 : 증강현실, 컴퓨터비전, SLAM, 머신 러닝

1987년 : 경상대학교 전산과(이학사)

1997년 : 숭실대학교 전산과(공학박사)

1989년~1992년 : 삼보컴퓨터

1997년~현재 : 경상대학교 컴퓨터과학과 교수

※관심분야:의료 영상 처리, 머신 러닝, SLAM, 영상 인식, 컴퓨터 네트워크