스토리텔링 기반 몰입형 가상현실 콘텐츠 제작 기법

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 스토리텔링 중심의 새로운 몰입형 가상현실 콘텐츠를 제작하기 위한 기법을 제안한다. 제안하는 기법은 사용자가 가상현실 콘텐츠를 체험하는 과정에서 콘텐츠의 전체적인 내용과 흐름을 쉽고 자연스럽게 인지할 수 있도록 가상환경에서의 영상 및 영화 기법을 활용한 새로운 방식의 시스템을 제공하는 것이 핵심 목적이다. 이를 위해 시네머신과 렌더 텍스처 렌더링 기법을 결합한 스토리 영상 제작 기법을 설계한다. 이는 가상현실 사용자의 시선에 따라 스토리 영상을 영화처럼 전달받음으로써 공간감과 몰입을 유지한 상황에서 콘텐츠 체험할 수 있는 환경을 제공한다. 여기에 오큘러스 퀘스트의 손 추적 기능을 통한 몰입형 상호작용을 설계하고 제작 기법에 대한 성능 검증과 비교 실험을 위한 콘텐츠를 제작한다. 마지막으로 기존의 GUI 방식과의 비교 설문 실험을 통하여 제안하는 기법이 가상현실 환경에서의 몰입을 유지하면서 만족도 높은 경험을 제공함을 확인한다.

Abstract

This study proposes a technique for creating new immersive virtual reality content centered on storytelling. The purpose method is that users can easily recognize the overall content and flow in the process of experiencing virtual reality content, and the key purpose is to provide a new system fo methods using video and movie techniques in the virtual environment. For this, we design a story video production technique that combines the Cinemachine and the render texture technique. This provides an environment in which a user can experience contents in situation where a sense of space and immersion is maintained by receiving a story image like a movie according to the gaze of a virtual reality user. In addition, we design immersive interactions through Oculus Quest’s hand tracking and create content for verification and comparison experiments on production techniques. Finally, comparative questionnaire experiment with the existing GUI method, it is confirmed that the proposed method provides a satisfactory experience while maintaining immersion in a virtual reality environment.

Keywords:

Storytelling-based Virtual Reality, Immersive Virtual Reality, Cinemachine, Production Techniques키워드:

스토리텔링, 가상현실, 몰입형 가상현실, 시네머신, 제작 기법Ⅰ. 서 론

가상현실(Virtual Reality)은 컴퓨터 기술을 통해 만들어진 가상 환경에서 사용자의 시각, 촉각, 청각 등의 오감을 자극하여 현실과 유사한 경험을 제공할 수 있도록 한다. 최근 컴퓨터 기술의 발전으로 단순한 체험형 가상현실 콘텐츠를 넘어 혼합현실, 실감 미디어 콘텐츠, 소셜 콘텐츠 등의 다중 체험 환경으로 늘어남에 따라 오큘러스 퀘스트(Oculus Quest), HTC 바이브(HTC Vive Pro), 홀로렌즈(Hololens) 등과 같은 HMD 장비의 수요가 증가하고 있다. 또 사용자의 신체를 활용하여 몰입형 가상환경을 체험하는 햅틱 시스템과 제한 된 공간에서 가상환경을 체험 가능한 트레드 밀, 모션 플랫폼에 관한 연구와 기술 개발이 진행되고 있다. 그리고 일정 크기의 공간 안에서 몰입감 높은 가상 환경과 경험을 제공하는 CAVE(Computer Aided exploration of Virtual Environment)와 같은 다양한 체험 환경을 제시하여 사용자에게 향상된 현존감을 제공하기 위한 연구들[1, 2, 3]과 관련된 응용 기술들이 개발되고 있으며, 사용자의 높은 접근성과 범용성을 고려한 쉽고 직관적인 구조의 인터페이스를 설계하여 몰입을 높일 수 있도록 사용자 시선, 손, 다리 등 신체를 활용한 몰입형 인터페이스 기술도 활용되고 있다[4, 5].

현재 가상현실 관련 다양한 기술들이 발전함에 따라 교육, 관광, 비디오 게임, 미디어 및 영화와 같은 엔터테인먼트 산업에서 교육, 의료 및 재활 트레이닝 등의 산업까지 확장되고 있다. 최근에는 사용자의 오감뿐만 아닌 사용자의 경험, 추억, 감정 및 감성을 활용한 새로운 실감형 콘텐츠 발전으로 사용자에게 새로운 경험을 제공하기 위해 인터렉티브 콘텐츠 기술 개발 및 연구가 꾸준히 진행되고 있다[6]. 대표적으로 영화 및 영상 미디어를 활용해 사용자에게 시각적 피드백을 포함한 높은 수준의 몰입을 제공하는 미디어 영상 콘텐츠로 단순 2D 이미지 형식으로 제공하지 않고 360˚ 카메라를 활용해 3D 공간감을 포함한 새로운 가상현실 콘텐츠의 한 분야로 제공되고 있다. 하지만 이러한 콘텐츠나 기술, 연구들은 가상현실 하드웨어 및 소프트웨어적인 접근과 콘텐츠의 다양성은 많이 부족한 상황이다. 또 스토리 중심의 콘텐츠에 가상현실 기술이 접목되고 있는 경우는 현재까지 단순 일회성 짙은 콘텐츠나 스토리 중심이 아닌 환경 체험 및 홍보를 위한 콘텐츠가 주를 이루고 있으며 지속적인 스토리 중심의 사용자 감정 및 오감을 제공하는 가상현실 콘텐츠가 현저히 부족한 상황이다. 더하여 영상을 활용해 몰입형 가상현실을 체험하기에 사용자의 역할과 상호작용 및 인터페이스의 연구 역시 부족한 상황이다.

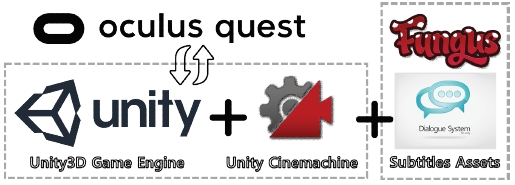

본 연구는 스토리 중심의 새로운 가상현실 콘텐츠 제작 기술과 방법을 제공해 다양한 산업 분야에 응용할 수 있도록 새로운 제작 기법을 제안한다. 또 단순 영상을 활용한 콘텐츠 체험이 아닌 사용자가 가상 환경과 상호작용 역시 가능하도록 영상기법을 활용한 새로운 통합 가상환경을 제공하고자 한다. 이를 위해 유니티(Unity3D) 엔진과 시네머신(Cinemachine) 패키지를 통합한 새로운 몰입형 가상현실 콘텐츠 제작방법을 설계한다.

Ⅱ. 관련연구

몰입형 가상현실을 위한 관련 연구들은 시각정보를 제공하는 HMD 기기에서부터 사용자의 신체를 활용한 새로운 인터페이스 및 시스템과 더불어 다양한 피드백을 제공하는 햅틱 시스템까지 폭넓게 이루어지고 있다. 또한, 가상현실을 체험하기 위한 사용자 체험 환경에 대한 장비의 최소화 및 다중 사용자를 위한 체험 공간 구성과 더불어 새로운 소셜 분야의 접근에 대한 연구들도 꾸준히 진행되고 있다. 높은 몰입을 통해 현실과 가까운 현존감을 제공하기 위해서는 가상과 실제 사이의 차이를 최소화하는 상호작용이 필요하다. 이를 위해 현실 공간에서 인체 관절의 변화를 감지하고, 동작의 의도를 표현하여 가상현실에서의 행동으로 정확히 반영하는 연구들이 수행되고 있다[7, 8]. 최근에는 모션 캡쳐 데이터를 기반으로 손 제스쳐에서부터 얼굴 표정, 몸 전체의 움직임을 가상 환경에 현실감있게 표현하는 연구[9]가 진행되기도 하였다. 또 접근성 높은 상호작용을 위하여 오큘러스 터치(touch) 컨트롤러를 사용자의 실제 손 제스쳐와 매핑하거나 스마트폰의 자이로 센서를 기반으로 객체를 제어하는 방법, 시선을 활용하여 가상 객체 또는 환경과 상호작용하는 방법 등이 최근까지 활발히 연구되고 있다[10, 11, 12].

몰입형 가상현실에서 사용자의 현존감을 높이기 위한 연구들을 토대로 엔터테인먼트는 물론 교육, 안전, 의료 등 다양한 산업 분야에 활용 가능한 콘텐츠 제작에 관한 연구들이 진행되고 있다. 이와 관련하여 가상현실을 기반으로 화학 사고에 대응하기 위한 훈련 콘텐츠 개발에 관한 연구[13], 애니메이션 분야에 가상현실 기술을 적용하기 위한 가상현실 애니메이션 연출법에 관한 연구[14], 교육용 콘텐츠로서 몰입형 전래동화 콘텐츠 제작을 위한 가상현실 기술에 대한 연구[15] 등 가상현실 기술을 다양한 콘텐츠 제작에 활용하기 위한 연구들이 폭넓게 진행되고 있다. 하지만, HMD 가상현실 사용자가 가상 환경 또는 객체와 상호작용하며 체험을 하는 동시에 스토리가 담긴 줄거리를 자연스럽게 전달하여 스토리에 몰입하여 체험할 수 있는 콘텐츠나 관련 기술에 대한 연구들은 부족한 상황이다.

몰입형 가상현실에서 스토리를 전달하는 방식으로 장면을 중심으로 하는 360˚ 가상현실이 있다. 이와 관련하여 단순 2D 이미지나 영상제공을 통한 몰입보다 3D 공간을 사용자에게 제공하여 공간감을 극대화하는 360˚ 카메라를 활용한 파노라마 영상제공 시스템 연구들이 진행되고 있다. 하지만 대부분 관련 영상제공 연구들은 단순한 사용자에게 시각적 피드백 및 시각정보 제공만으로 극대화된 몰입과 현존감을 제공하지 않는다. 이를 극복하기 위해 영상과 상호작용을 진행할 수 있는 새로운 인터페이스 연구들이 진행되고 있다. 최근 다수의 콘텐츠는 일회성 짙은 콘텐츠로 사용자가 한 번의 체험 이후 콘텐츠의 활용성이 현저히 낮아짐을 확인할 수 있다. 이러한 문제를 해결하기 위해 스토리나 내용이 담긴 새로운 스토리 기반의 가상현실 콘텐츠가 제작되고 있으나 이 역시 사용자와 가상 환경에서 상호작용하는 사례가 존재하지 않는다.

본 연구는 이러한 연구 배경을 토대로 가상현실 사용자 스토리 중심에서 전체적으로 내용과 상황을 인지하고 가상 환경과 상호작용이 가능한 새로운 스토리텔링 기반 몰입형 가상현실 콘텐츠 구현을 위한 제작 기법을 제안한다.

Ⅲ. 스토리중심 몰입형 가상 환경 제작 기법

3-1 개요

본 연구는 가상현실 사용자가 체험하는 콘텐츠의 전체적인 흐름과 스토리의 내용을 쉽게 인지할 수 있도록 2D 영상을 통해 정보를 제공하고 가상 환경과 쉽고 편리하게 상호작용이 가능한 형태의 새로운 스토리 중심의 몰입형 가상현실 콘텐츠 제작 기법을 정의하는 것이 핵심 목적이다. 그림 1은 본 연구에서 제안하는 제작 기법으로, 사용자에게 입체감 높은 가상현실 환경에서 스토리를 효과적으로 전달하면서 가상 환경과 상호작용할 수 있는 방법을 정의한 것이다. 가상현실 사용자는 오큘러스 퀘스트를 활용하여 장소에 구애받지 않고 자유롭게 체험할 수 있도록 한다. 사용자가 전체적인 콘텐츠의 흐름과 스토리를 쉽고, 효과적으로 확인하기 위해 유니티 엔진과 시네머신을 사용하여 스토리 및 정보가 담긴 2D 이미지를 3D 공간에 표현하는 기법을 제안한다. 또한, 가상현실을 체험하는 사용자에게 몰입감을 극대화하기 위해 사용자의 실제 손을 가상환경에 정확하게 반영하고 이를 활용해 가상 환경과 상호작용을 제공한다.

3-2 몰입형 가상환경

가상현실 사용자는 독립된 하나의 캐릭터로써 다양한 제스처 또는 행동을 통해 가상환경, 객체들과 직접적인 상호작용이 가능하다. 이때, 사용자의 몰입을 높이기 위해서는 가상 환경과 직접적이면서 현실감있는 상호작용을 제공해야 한다. 본 연구는 사용자가 실제 손을 직접 사용하여 가상환경 또는 객체들과 상호작용하고 공간의 제약 없이 자유로운 환경에서 체험할 수 있도록 오큘러스 퀘스트를 활용한다. 오큘러스 퀘스트는 자체 시스템 내 사용자의 PC와 쉽게 연결을 제공하는 링크 시스템을 활용하여 기존 오큘러스 리프트(Rift)와 같은 일정 공간을 활용한 위치 추적 체험이 가능하고, 독립형 플랫폼으로써 모바일 어플리케이션 빌드를 통해 사용자가 장소에 구애받지 않고 어디서든 체험할 수 있는 특징이 있다. 또 사용자의 손을 실시간으로 추적이 가능한 시스템 기능을 포함하고 있어 사용자에게 높은 몰입을 제공하는 상호작용 설계가 가능하다.

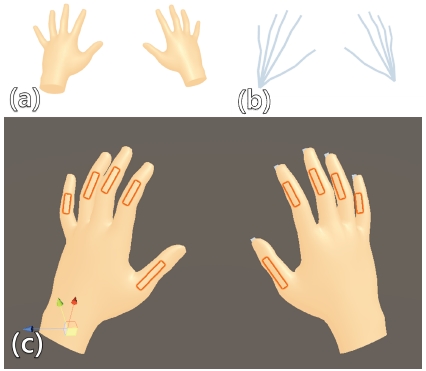

유니티 엔진을 기반으로 오큘러스 퀘스트를 활용하여 개발환경을 구현하는 과정은 다른 기존 오큘러스 기기(리프트, 고 등)를 통해 구현하는 과정과 같다. 유니티 엔진의 에셋 스토어에서 제공하는 유니티 통합(Interfaration) 패키지[16]를 임포트하고 패키지내 제공하는 프리팹을 활용하여 구현한다. OVRCameraRig을 통해 사용자에게 해당 디스플레이의 좌,우 카메라로 렌더링되는 장면을 계산하고 HMD의 위치와 방향을 추적하여 정확한 시각정보를 제공하도록 설정되어 있다. 또 사용자에게 높은 몰입을 제공하는 손 추적 시스템을 활용하기 위해 퀘스트 장비 시스템의 손 추적 기능을 활성화하고 전용 링크 케이블을 활용해 작업할 데스크톱과 연결을 진행한다. 연결된 퀘스트 장비를 확인 후 OVRHandPrefab을 왼손, 오른손 각각 알맞게 배치하고 사용하고자 하는 렌더링 모드와 손의 위치, 방향 등 속성들을 일괄 관리가 가능한 스크립트(HandManager)를 등록하여 가상환경에 배치된 손을 알맞게 설정해준다. 그리고 해당 연구에서 제안하는 몰입형 가상 환경은 사용자가 가상 환경과 쉽게 상호작용이 가능하도록 퀘스트 손 추적 시스템을 활용하기 때문에 배치된 가상 손의 스켈레톤과 충돌체(Collider) 및 속성(Enable Physics Capusles)을 활성화하여 쉽게 객체들과 상호작용이 가능하도록 설정한다. 그림 2는 오큘러스 퀘스트의 기본적인 손 모델과 상호작용을 가능하도록 생성하는 스켈레톤 및 활성화되어 있는 충돌체를 확인할 수 있다.

3-3 시네머신 영상 제작 기법

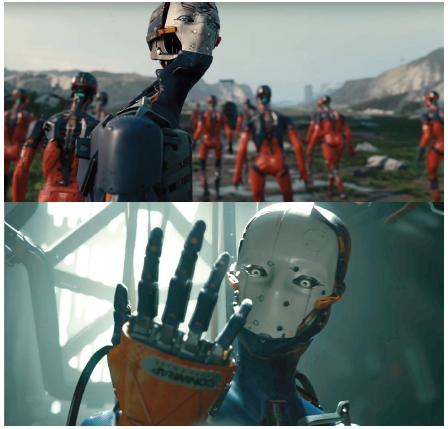

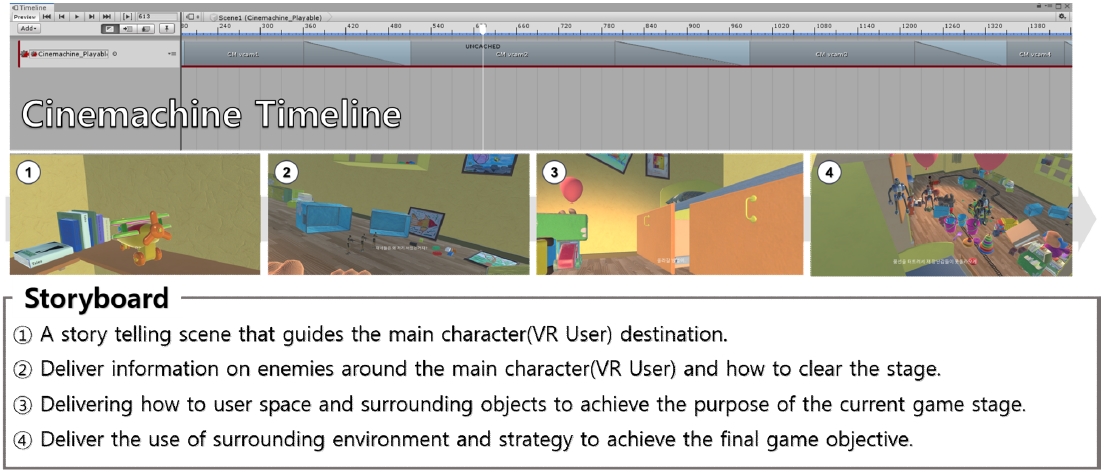

콘텐츠 제작을 위해 자주 사용되는 유니티 엔진에서 다양한 영상 효과, 영화 기법을 표현하기 위해 대부분 유니티 기능에 포함된 비디오 속성을 활용하였다. 최근에는 사전에 영상을 촬영하여 유니티에서 영상을 플레이하는 형식이 아닌 가상환경에서 실시간 또는 만들고자 하는 장면을 생성하는 영상 및 영화 기법인 시네머신[17]을 통해 사용자들이 다양한 콘텐츠에 활용하고 있다. 시네머신을 통해 유니티에서 2D 스토리 제작을 위해 배치한 카메라(장면 촬영, 타임라인 등)들을 일괄적으로 관리할 수 있고, 1인칭 시점 장면부터 가상 객체를 따라 다니는 팔로우 카메라 기능, 실시간으로 플레이 장면을 촬영하는 실시간 컷 장면 기능까지 사용자가 다양한 카메라 기능을 활용하여 콘텐츠의 내용과 스토리를 쉽게 추가할 수 있다. 그림 3은 유니티 시네머신을 활용하여 영상 콘텐츠와 게임 콘텐츠 내 영화 기법을 포함해 사용자에게 풍족한 시각적 효과와 새로운 기술과 몰입을 선보인 대표적인 활용 사례이다[18].

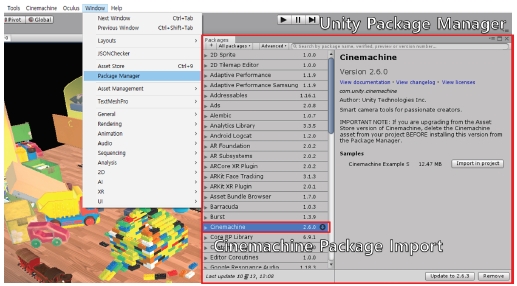

시네머신을 통한 유니티 개발환경 구축 과정은 그림 4와 같이 유니티의 패키지 설정 및 패키지 관리자에서 사용하고자 하는 시네머신 패키지를 임포트하여 유니티 에디터 탭에 시네머신 전용 탭을 추가한다. 해당 탭에서는 사용자가 원하는 장면을 쉽게 표현할 수 있으며, 제어하기 편리한 일반적인 가상 카메라(Virtual Camera, Vcam)와 제작하고자 하는 장면의 전체적인 장면을 원하는 위치에서 제어하며 확인할 수 있는 자유 시점 카메라(FreeLook Camera), 사용자가 원하는 장면을 우선 구성하고 카메라가 일정 트랙이나 카트를 따라 움직이며 동적으로 영상을 보여주기 위한 트랙 및 카트 카메라(Dolly Camera with Track, Dolly Track with Cart), 2D 영상을 쉽게 제작하는 2D 카메라까지 다양한 시네머신 카메라가 존재한다. 본 연구에서는 사용자가 원하는 장면을 비교적 쉽고, 빠르게 제작하기 위해 기본 가상 카메라를 활용하여 제작한다.

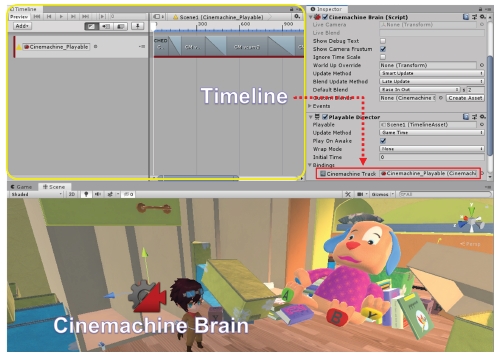

그림 5는 시네머신의 가상 카메라를 활용하여 기본적인 영상 및 미디어 재생 방법을 나타낸 것으로 사용하고자 하는 카메라를 클릭 후 생성된 가상 카메라의 속성에서 기본적인 카메라의 방향과 위치를 설정하고 시네머신 가상 카메라 스크립트에서 원하는 객체 추적, FoV, 다양한 카메라 효과 등을 설정한다. 이후 기본 설정이 끝난 가상 카메라를 영상처럼 실행하기 위해 시네머신의 타임라인 창을 활용하여 프레임에 따라 설정된 가상 카메라의 위치나 방향이나 효과 등 설정한다. 설정된 타임라인은 영상 및 영화의 한 장면으로 표현이 되는 것이다. 이후 빈 가상 객체를 생성하고 시네머신에 포함된 카메라들과 프로젝트 파일들을 일괄 제어 및 관리하는 스크립트(Cinemachine Brain)와, 만들어진 타임라인의 영상 실행 및 정지와 같은 영상 제어를 관리하는 스크립트(Playable Director)를 추가한다. 마지막으로 추가한 Playable Director 스크립트 속성 중 실행하고자 하는 타임라인을 Playable 변수에 추가하면 프레임이 경과 함에 따라 자연스럽게 타임라인에서 설정한 동작들이 영상처럼 표현되는 것을 확인할 수 있다.

Basic development environment and time line setting method for image management (play, stop, etc.) and camera placement of Cinemachine

그림 6은 그림 5의 설정 방법을 토대로 가상 카메라가 촬영한 프레임별 영상들이 실행되는 과정을 보여주고 있다. 사용자가 사전에 정의 또는 기획한 스토리보드의 내용을 토대로 스토리 또는 메시지를 정확하고 몰입감있게 전달하는 것이 제안하는 제작 기법의 핵심 목표이다.

3-4 스토리텔링 기반 가상환경 구축

유니티 시네머신은 일반적인 2D, 3D 게임에서 영상을 활용하여 사용자들의 시각적 피드백을 자극해 높은 몰입을 제공하고 있다. 또 영화나 미디어에서 자주 활용되고 있으나 몰입형 가상현실을 비롯한 가상환경에서 적용한 사례는 극히 드물다. 이는 시네머신의 가상 카메라(Virtual Camera, VCam)로부터 생성된 2D 영상을 별도의 처리 과정 없이 가상현실 HMD로부터 전달되는 3D 공간에서 표현하게 되면 일반적인 GUI와 차이가 없어 스토리를 효과적으로 전달하는데 한계가 있다. 따라서 본 연구는 가상현실 사용자의 입체적인 시각정보를 통한 3D 공간감을 유지하면서 동시에 2D 영상을 통한 스토리를 효과적으로 전달하는 제작방법을 새롭게 정의한다.

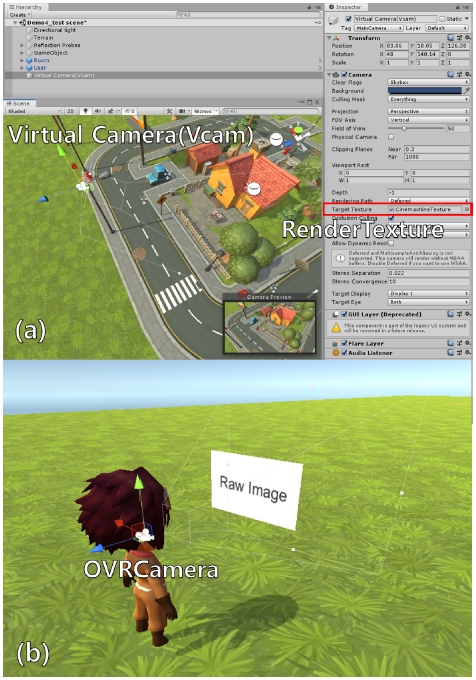

시네머신의 가상 카메라를 사용하는 경우 유니티 개발환경에서 사용되는 모든 카메라가 자동으로 가상 카메라로 인식되기 때문에 카메라가 촬영하는 화면을 다른 특정 이미지에서 보여주는 방식을 활용한다. 해당 방식을 사용하기 위해 유니티의 렌더 텍스처(RenderTexture) 기능을 사용해 시네머신의 가상 카메라로부터 촬영된 장면을 OVRCameraRig로 전달한다. 렌더 텍스처는 유니티 런타임에서 생성 및 갱신되는 특수한 텍스처이다. 우선, 프로젝트 내 새로운 렌더 텍스처를 생성하고 사용하고자 하는 카메라 중 하나를 지정하여 해당 카메라의 렌더링 장면을 텍스처로 저장한다. OVRCameraRig에서 사용자의 정확한 중앙과 시야 계산을 통해 쉽게 렌더링을 제공하는 CenterEyeAnchor 카메라 객체 하위에 이미지 혹은 텍스처를 제공하는 캔버스(Canvas)를 추가하고, 사용자의 시야 거리 앞 방향으로 이미지(RawImage)를 생성하여 생성된 이미지에 렌더 텍스처를 출력한다. 이를 통해 사용자가 시네머신 가상 카메라가 촬영하는 프레임별 2D 영상을 항상 시야 정면에서 영화를 보듯이 효과적으로 확인할 수 있다. 그림 7은 렌더 텍스처를 포함한 OVRCamera의 설정 방법과 시네머신의 가상 카메라를 촬영하여 렌더 텍스처로 저장하는 개발환경을 나타낸 것이다. 그림 6의 중앙 이미지는 그림 6의 하단 스토리보드를 기반으로 가상현실 사용자의 시점에서 시네머신의 가상 카메로부터 촬영된 영상을 렌더 텍스처로 전달하여 표현된 결과이다. 사용자가 HMD를 움직여도 항상 시야 정면에서 2D 영상으로 스토리를 전달하기 때문에 스토리에 집중하면서 가상공간에서의 몰입을 유지할 수 있다.

Building a virtual environment to show Cinemachine images: (a) place virtual camera on Cinemachine and set RenderTexture, (b) place the OVRcamera and rawImage for image execution

또 몰입형 가상현실에서의 사용자 상호작용을 제공하기 위해 콘텐츠의 영상 및 이미지의 내용이 계속되는 것이 아닌 내용확인 후 가상환경 체험형식으로 콘텐츠를 구성하여 사용자가 가상 환경과 상호작용을 통해 다양한 내용 구성과 스토리가 진행될 수 있도록 콘텐츠를 제공하는 것으로 극대화된 몰입을 제공할 것이다. 이를 위해 영상 및 이미지가 가상환경으로 다시 전환되기 위해 영상기법에서 일반적으로 사용되는 페이드 인-아웃(Fade In-Fade Out) 방법을 활용해 사용자에게 몰입을 저하하는 부정적인 요인인 눈의 피로를 제거하고, 자연스러운 전개를 통해 몰입을 유지 시키도록 설계한다.

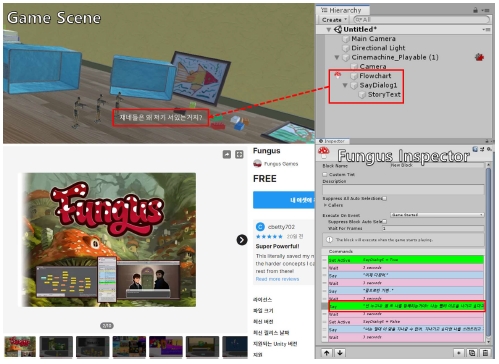

마지막으로 콘텐츠의 내용을 비교적 빠르게 전달하고 이해를 쉽게 제공하기 위해 본 연구에서 2D 영상과 함께 자막 제공 기능을 설계한다. 이를 위해 그림 8과 같이 유니티 에셋 스토어에서 제공하는 Fungus 자막 패키지[19]를 임포트해 앞서 설계한 OVRCameraRig의 하위 객체에 해당 패키지에서 쉽게 제공하는 자막 객체를 등록하여 사용자에게 영상과 자막을 가상환경에서 동시에 확인할 수 있는 통합 환경을 설계한다.

Ⅳ. 실험 및 분석

제안하는 스토리텔링 기반 몰입형 가상현실은 표 1의 개발 및 실험 환경을 토대로 사용자들이 쉽게 콘텐츠의 전체적인 내용와 스토리를 인지하고 가상 환경과의 상호작용을 쉽게 제공하는 제작 기법을 구현하였다. 또 가상현실 사용자는 오큘러스 퀘스트 HMD를 착용한 상태에서 손을 직접 사용할 수 있도록 제공하였다. 그림 9는 가상현실 사용자가 체험하는 실험 환경을 나타낸 예로 가상현실 사용자는 편하게 앉거나 서서 체험할 수 있는 정도의 여유로운 공간으로 구성하였다.

그림 10은 에셋 스토어의 리소스[20]를 활용하여 제작 공정을 통해 제작된 프로토타입 콘텐츠를 나타낸 것으로, 체험을 진행하는 가상현실 사용자는 콘텐츠의 전체적인 스토리 흐름과 내용을 인지하면서 시네머신의 영상이 끝나고 가상환경을 체험할 수 있는 구조로 진행된다. 또 특정 상황이나 미션을 수행하였을 때 시네머신으로 제작된 스토리가 담긴 영상이 실행되며 기존의 스토리에서 확장되거나 다른 스토리가 진행되는 장면을 제공하여 사용자가 가상환경에서 3차원 공간감을 유지한 체 다양한 상호작용에 따른 스토리 전개 또는 스토리에 깊이 있게 몰입할 수 있는 콘텐츠로 구성하였다.

다음은 제안한 스토리텔링 제작 기법을 활용한 가상현실 콘텐츠를 체험하는 사용자에게 몰입감을 충분히 제공하였는지를 확인하기 위해 그림 9의 체험 환경에서 사용자를 대상으로 제안하는 몰입형 가상현실에 대한 현존감과 스토리 전달 방식의 만족도를 비교 분석하는 설문 실험을 진행하였다. 설문 실험은 제안하는 시네머신과 렌더 텍스처 영상 표현 방법과 단순히 GUI를 통해 평면적으로 제공되는 이미지 및 자막 제공 방식을 비교 체험하는 과정으로 진행한다.

체험하는 설문 참가자는 23~38세 사이의 총 16명(남: 10명, 여: 6명)으로 구성되었다. 설문의 핵심 목적은 사용자가 스토리를 전달받는 과정에서 가상현실에 대한 몰입을 방해하지 않고 현존감을 유지하는지 여부를 확인하는 것과 스토리 전달 방식에 대한 전체적인 만족도를 분석하는 것이다. 설문 참가자는 제작된 실험용 콘텐츠(그림 10)를 제안하는 제작 기법이 적용된 장면과 단순 평면 이미지로 제공하는 장면 그리고 자막만으로 내용을 전달하는 식으로 각각 한 번씩 체험하게 된다.

우선, 가상현실에서의 몰입 및 현존감 유지를 객관적으로 분석하기 위하여 Witmer et al.[21]에 제안한 현존감 설문지를 활용하였다. 현존감 설문지는 realism, possibility to act, quality of interface 등 현존감에 대한 종합적인 분석을 위한 다양한 설문 문항으로 구성되어 있다. 본 연구는 몰입과 현존감 유지 여부를 분석하기 위하여 realism 항목 대한 질문들로 설문을 진행하였다. 다음으로 스토리 전달 과정에 대한 만족도 분석을 위하여 Arnold Lund의 usefulness, satisfaction, and ease of use (USE) 설문지[22] 항목 중 만족도 분석을 위한 설문 문항으로 실험을 진행하였다. 두 설문 실험의 응답은 “전혀 동의할 수 없다”에서 “매우 만족한다”를 1~7 사이 값으로 기록하도록 하였다. 이때 7은 만족의 최대값을 의미한다.

표 2는 설문 결과를 정리한 것으로 가상현실에서의 현실감을 토대로 현존감을 어느 정도 유지하고 있는지를 분석한 결과 공간감을 최대한 높이면서 스토리 영상을 제공하는 본 연구의 기법이 평균 5.817로 가장 높게 기록됨을 확인할 수 있다. 이미지나 자막으로 제공되는 기존의 방식은 HMD를 통해 입체적인 장면을 제공하는 과정에서 2차원 정보가 전달됨으로 인해 사용자의 몰입을 방해하는 원인으로 분석되었다. 또 사용자가 콘텐츠의 내용을 이해하는 부분에 있어, 이전 장면과 다음 상황의 장면이 연결되는 시각적 정보와 3차원 공간을 같이 확인하여 내용을 인지하는 시간이 부족하여 제안하는 시네머신 영상을 활용한 방법보다 콘텐츠의 전반적인 이해도가 낮음을 역시 확인하였다. 만족도 역시 평균 6.188의 값으로 제안하는 기법이 스토리와 콘텐츠의 흐름을 정확히 파악하면서 결과적으로 콘텐츠의 흥미를 높이는 긍정적인 역할을 함을 알 수 있었다. 이미지나 자막으로 제공되는 방식은 현존감과 마찬가지로 콘텐츠를 정확히 이해하고 체험하는데 적절한 도움을 주지 못한다는 것을 설문 결과 확인할 수 있었다. 마지막으로, one-way ANOVA를 통한 통계적 유의성을 확인한 결과 현존감, 만족도 모두 유의미한 차이를 나타냄을 알 수 있었다.

Ⅴ. 결 론

본 연구는 가상현실 사용자가 단순 일회성 짙은 콘텐츠를 체험하는 방식과 달리 스토리와 내용 중심의 새로운 몰입형 가상현실 콘텐츠를 체험할 수 있도록 유니티 시네머신을 활용한 새로운 스토리테링 기반 몰입형 가상현실 콘텐츠 제작 기법을 정의하였다. 가상현실 사용자는 PC는 물론 이동 체험이 가능한 독립형 HMD인 오큘러스 퀘스트와 개발 도구를 활용하여 가상 환경을 구축하였으며, 스토리 및 내용을 시각적으로 표현을 극대화하는 영상을 쉽게 제작하기 위해 유니티 엔진에서 제공하는 시네머신을 활용하여 사용자가 가상 환경에서 영상 및 영화 기법을 통해 더욱 높은 몰입을 제공할 수 있도록 통합 구현하였다. 여기에 사용자가 가상환경에서 다양한 상호작용에 따른 각기 다른 내용 및 스토리 전달을 통해 기존 가상현실 콘텐츠를 체험하는 것보다 높은 몰입과 흥미를 받는 것을 프로토타입 콘텐츠를 직접 제작 및 실험 분석을 통해 증명하였다.

Acknowledgments

이 논문은 2020년 문화체육관광부의 재원으로 한국콘텐츠진흥원의 위탁을 받아 수행된 연구임. (김민규, Mingyu Kim) 또한, 본 연구는 한성대학교 교내학술연구비 지원과제 임(김진모, Jinmo Kim)

References

-

Z.C. Dong, X.M. Fu, C. Zhang, K. Wu, and L. Liu, “Smooth Assembled Mappings for Large-scale Real Walking,” ACM Transactions on Graphics, Vol. 36, No. 6, pp. 211:1–211:13, November 2017.

[https://doi.org/10.1145/3130800.3130893]

-

S. Marwecki, M. Brehm, L. Wagner, L.P. Cheng, F.F. Mueller, and P. Baudisch, “VirtualSpace-Overloading Physical Space with Multiple Virtual Reality Users,” In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems. CHI ’18, New York: NY, pp. 241:1–241:10, 2018.

[https://doi.org/10.1145/3173574.3173815]

-

J. Lee, K. Jeong, and J. Kim, “MAVE: Maze-based immersive virtual environment for new presence and experience,” Computer Animation and Virtual Worlds, Vol. 28, No. 3-4, e1756, May 2017.

[https://doi.org/10.1002/cav.1756]

-

M. Kim, J. Lee, C. Jeon, and J. Kim, "A Study on Interaction of Gaze Pointer-Based User Interface in Mobile Virtual Reality Environment," Symmetry, Vol. 9, No. 9, 189, September 2017.

[https://doi.org/10.3390/sym9090189]

-

S. Han, and J. Kim, “A Study on Immersion of Hand Interaction for Mobile Platform Virtual Reality Contents,” Symmetry, Vol. 9, No. 2, 22, February 2017.

[https://doi.org/10.3390/sym9020022]

-

J. Kang, “A Study on Emotionally Responsive Interactive VR Films Using Wearable Band,” Journal of Digital Contents Society, Vol. 20, No. 4, pp. 707-715, Apr. 2019.

[https://doi.org/10.9728/dcs.2019.20.4.707]

-

Metcalf, C. D., Notley, S. V., Chappell, P. H., Burridge, J. H., and Yule, V. T, “Validation and application of a computational model for wrist and hand movements using surface markers,” IEEE Transactions on Biomedical Engineering, Vol. 55, Issue. 3, pp. 1199-1210, Mar 2008.

[https://doi.org/10.1109/TBME.2007.908087]

- Zaho, W., Chai, J., and Xu, Y. Q, “Combining marker-based mocap and RGB-D camera for acquiring high-fidelity hand motion data,” In Proceedings of the ACM SIGGRAPH/eurographics symposium on computer animation, pp. 33-42, July 2012.

-

H. Joo, T. Simon, and Y. Sheikh, “Total Capture: A 3D Deformation Model for Tracking Faces, Hands, and Bodies,” in 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, pp. 8320-8329,2018.

[https://doi.org/10.1109/CVPR.2018.00868]

-

M. Kim, J. Kim, K. Jeong, and C. Kim. “Grasping VR: Presence of Pseudo-Haptic Interface Based Portable Hand Grip System in Immersive Virtual Reality,” International Journal of Human–Computer Interaction, Vol. 36, No. 7, pp. 685–698, April 2020.

[https://doi.org/10.1080/10447318.2019.1680920]

-

W. Park, H. Heo, S. Park, and J. Kim. “A Study on the Presence of Immersive User Interface in Collaborative Virtual Environments Application,” Symmetry, Vol. 11, No. 4, 476, April 2019.

[https://doi.org/10.3390/sym11040476]

-

N. Sidorakis, G.A. Koulieris, and K. Mania. “Binocular eye-tracking for the control of a 3D immersive multimedia user interface,” In 2015 IEEE 1st Workshop on Everyday Virtual Reality (WEVR), pp. 15–18, 2015.

[https://doi.org/10.1109/WEVR.2015.7151689]

-

S. An, K. Lim, H. Go, G. Jung, and B. Ma. “A Study on Development of Multi-user Training Contents for Response to Chemical Accidents based on Virtual Reality,” Journal of Digital Contents Society, Vol. 21, No. 1, pp. 1-10, Jan 2020.

[https://doi.org/10.9728/dcs.2020.21.1.1]

-

J. Kim, J. Kim, and B. Rhee. “A Study on the Directing Method of VR Animation : Focusing on <DreamTherapy>,” Journal of Digital Contents Society, Vol. 20, No. 9, pp. 1789-1798, Sep. 2019.

[https://doi.org/10.9728/dcs.2019.20.9.1789]

-

K. Jeong, S. Han, D. Lee, and J. Kim. “A Study on Virtual Reality Techniques for Immersive Traditional Fairy Tale Contents Production,” Journal of The Korea Computer Graphics Society, Vol. 22, Issue. 3, pp. 43-52, July 2016.

[https://doi.org/10.15701/kcgs.2016.22.3.43]

- Oculus Integration for Unity [Internet]. Available: https://developer.oculus.com/downloads/package/unity-integration/

- Unity Cinemachine Tutorials [Internet], Available: https://unity.com/kr/unity/features/editor/art-and-design/cinemachine

- Unity ADAM: Episode 1 [Internet], Available: https://www.youtube.com/watch?v=GXI0l3yqBrA&ab_channel=Unity

- Fungus for Unity [Internet], Available: https://assetstore.unity.com/packages/templates/systems/fungus-34184

- Cartoon Town and Farm for Unity [Internet], Available: https://assetstore.unity.com/packages/3d/environments/cartoon-town-and-farm-17254

-

B. -G. Witmer, C. -J. Jerome, and M. -J. Singer, “The Factor Structure of the Presence Questionnaire,” Presence: Teleoper. Virtual Environ., Vol. 14, No. 3, pp. 298-312, June 2005.

[https://doi.org/10.1162/105474605323384654]

- A. Lund, “Measuring Usability with the USE Questionnaire,” Usability & User Experience, Vol. 8, No. 2, Oct 2001.

저자소개

2018년 : 부산가톨릭대학교 소프트웨어학과 (공학사)

2020년 : 고려대학교 대학원 영상정보처리협동과정 (공학석사)

※관심분야:가상현실(Virtual Reality), 증강현실(Augmented Reality), 컴퓨터그래픽스(Computer Graphics), 실감형 콘텐츠(Immersive Contents) 등

2006년 : 동국대학교 컴퓨터·멀티미디어공학부 (공학사)

2008년 : 동국대학교 영상대학원 멀티미디어학과 (예술공학석사)

2012년 : 동국대학교 영상대학원 멀티미디어학과 (공학박사)

2012년~2014년: 동국대학교 영상문화콘텐츠연구원 전임연구원

2014년~2019년: 부산가톨릭대학교 소프트웨어학과 조교수

2019년~현 재: 한성대학교 컴퓨터공학부 조교수

※관심분야:컴퓨터그래픽스(Computer Graphics), 가상현실(Virtual Reality), 증강현실(Augmented Reality), 실감형 미디어(Immersive Media), 게임 공학(Game Engineering) 등