감정 전이와 실시간 얼굴 표정 리타게팅 기술 기반 음악 감상 경험 증진에 관한 연구

Copyright ⓒ 2019 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

음악 청취 중 감정적 경험은 종종 사회적 환경에 의해 촉진된다. 집단 음악 감상에서 청중은 다른 청자의 얼굴 표정과 같은 단서를 기반으로 주위의 사람들과 자신의 감정을 수렴시키는 감정 전이 현상을 경험한다. 본 논문에서는 이러한 감정전이 현상과 실시간 얼굴 표정 리타게팅 기술을 활용한 새로운 음악 감상 시스템을 제안한다. 제안하는 시스템은 음악이 내포한 감정을 표정으로 연기하는 가상 캐릭터와 함께 음악을 감상하는 경험을 제공하는 것을 목적으로 한다. 시스템의 효과성을 검증하기 위하여 20대 대학생 100명을 대상으로 한 실험연구를 진행하였으며 제안하는 시스템이 음악 감상에서 청자에게 더 큰 감정을 유도하는 것으로 나타났다. 이 시스템은 라이브 음악 콘서트 등의 환경에서 실시간으로 상황, 청중에 맞춘 캐릭터 애니메이션을 생성하는 새로운 엔터테인먼트 경험 제공 목적 외에도 악곡 구조 이해를 돕거나 청각장애인들이 음악을 시각적으로 이해하도록 돕는 데 사용될 수 있다.

Abstract

An emotional experience in music listening is often facilitated by social contexts. During group music listening, audiences experience ‘emotional contagion’, the tendency that audiences converge their emotions to other co-located listeners’ by their physical cues such as facial expressions. We propose a character-assisted music listening system based on the emotional contagion and real-time facial expression retargeting technology. It provides an audience with a novel live entertainment experience using an animated character that shows facial expressions and head movements of a human performer in real-time. From a preliminary user study with 100 college students in 20s, our experiment has shown positive results in enhancing the audience emotions during music listening. Beyond live entertainment, the proposed system can also be used to help one who has a problem with appreciating music or a hearing-impaired individual to better understand music.

Keywords:

Emotional contagion, Music listening, Facial expression retargeting, Virtual character, Performance capture키워드:

감정전이, 음악 감상, 표정 리타게팅, 가상 캐릭터, 퍼모먼스 캡쳐Ⅰ. 서 론

감정 유발은 음악 감상 경험의 결정적인 요소이다. 사람들은 음악으로부터 기쁨, 슬픔, 화, 두려움 등의 감정을 인지할 수 있으며, 종종 강한 흥분이나 전율 등의 감정이 언어보다 효과적으로 유도된다[1]-[5]. 청자가 음악에 반응하는 인지 과정 전반에 대한 모든 구체적인 사항이 밝혀지진 않았으나, 대부분의 음악 심리학자들은 음악이 청자가 인지 가능한 감정을 표현할 수 있으며, 이러한 음악 감정이 청자들에게 전이성을 가진다는 것에 동의한다[2]. 이에 따라, 휴먼-컴퓨터 인터랙션 연구자들은 연주 퍼포먼스 중 감정 전이 경험을 향상시킬 수 있는 인터랙티브 시스템에 관심을 가져왔다[6, 7].

음악 청취 중 더 강한 감정적 경험은 종종 사회적 환경에 의해 촉진된다. 예를 들어, 청자들은 사랑하는 사람과 함께 있거나, 혹은 다른 관객과 함께 콘서트홀에서 연주를 감상할 경우, 듣고 있는 음악에 더 큰 반향이 유발되는 현상을 종종 경험한다. 이러한 현상이 발생하는 가장 큰 이유는 청중이 자신의 감정을 주변 사람들의 감정과 동기화시키는 경향 때문으로, 심리학에서는 인간의 감정 전이 현상 (Emotional contagion) 으로 부른다[8]. 함께 음악을 듣는 청자들은 의식적/무의식적으로 다른 청자의 얼굴 표정과 같은 물리적 단서를 기반으로 주위의 사람들과 자신의 감정을 수렴시키는 경향이 있다[9, 10].

최근 모션 캡쳐 기술이 크게 발전하면서 특수 장비나 얼굴에 마킹없이 카메라와 일반 컴퓨터로 실시간으로 얼굴 상의 여러 특징점 위치를 찾고 비교적 정확하게 추적하는 것이 가능해졌다[11]. 또한, 획득된 데이터들은 리타게팅 (Retargeting) 기술을 통해 실시간으로 캐릭터의 3D 얼굴 모델의 머리 움직임과 표정을 생성하는 데 사용될 수 있다. 3D 캐릭터는 모델의 형태에 제약이 없어 원하는 형태와 느낌으로 모델링할 수 있으므로, 사용자들의 성향, 감상 행태에 따른 커스터마이징이 가능하다. 이러한 얼굴 표정 실시간 리타게팅 기술과 3D 모델링 기술은 청자들에게 몰입 음악 환경을 구현하고, 새로운 엔터테인먼트 경험을 제공할 수 있는 가능성을 가진다.

이 논문에서는 감정 전이 원리와 실시간 얼굴 표정 리타게팅 기술을 활용한 새로운 음악 감상 시스템을 제안한다. 제안하는 시스템은 음악이 내포한 감정을 표정으로 연기하는 가상 캐릭터와 함께 음악을 감상하도록 하여 새로운 엔터테인먼트 경험을 제공하는 것을 목적으로 한다. 시스템의 효과성을 검증하기 위해 20대 대학생 100명을 대상으로 실시한 실험에서, 제안하는 방식 기반의 음악 감상이 일반적인 음악 감상보다 청자의 반응 감정을 더 강하게 유도하는 것으로 나타났다. 이 시스템은 일반 청자들을 위한 엔터테인먼트 목적 외에도 어려운 음악에 대한 이해를 돕거나 청각장애인들이 음악을 시각적으로 이해하도록 돕는 데 사용될 수 있다.

Ⅱ. 관련 연구

2-1 음악 감상에서 맥락적 요소

음악 감상 경험에서 음악적 요소(악곡 구조), 개인적 요소(개인의 곡 선호도 및 감정 상태), 맥락적 요소(감상 환경)는 서로 깊게 상호작용하며 청자의 전체 경험 만족도에 영향을 준다[12]. 연구자들은 템포, 세기, 조음 등 음악적 요소들과 청자의 감정 기제와의 연결에 대한 연구[13]에서 더 나아가, 음악 감상에 있어 맥락적 요소의 영향에 대해 연구해 왔다. 가령, 콘서트와 같은 집단 몰입 음악 환경은 강력한 음악적 경험을 촉발하며[14, 15], 타 관객들과 함께 듣는 몰입 경험은 청자 간 동질감을 형성해 더 강렬한 음악적 경험을 돕는다[16]. 한편, Liljeström 외 연구팀은 50명 대학생을 대상으로 음악 감상의 개인적 요소와 맥락적 요소가 청자의 경험 만족도에 미치는 영향을 탐구하였다. 청자가 곡을 직접 선택하고, 청자가 알고 있는 타인과 함께 감상할 경우, 행복감, 즐거움, 감탄 등의 긍정적인 감정이 개인적으로 감상할 때 보다 더 강하게 느껴진다고 보고되었다[17]. 또 다른 연구에서는 맥락적 요소 중 음악이 전달되는 공간의 특성에 따라 생기는 소리의 반향 차이가 청자의 음악 감상 중 감정적 경험에 영향을 미친다는 것을 발견하였다[18].

2-2 캐릭터와 감정 전이

Kamiyama 등은 음악 감정과 얼굴 표정간 상호작용에 관한 연구에서 음악 감정에 맞는 얼굴 표정 정보를 음악 감상에 앞서 미리 보여줬을 때, 청자들은 음악 감상 중 해당 감정을 더 빠르게 발견한다고 보고하였으며[19], Thompson 등도 음악 감상에서 연주자의 표정과 같은 시각적 정보가 제시될 경우 청자들에게 보다 강한 감정 유발을 일으킨다고 보고하였다[20]. 이는 얼굴 표정을 통해 더 효과적이고 빠른 음악 감정의 전달 또는 유도가 가능함을 보여준다. 한편, 3D 캐릭터를 사용한 멀티미디어 음악 감상 경험은 음악 감상 경험 중 몰입도와 만족도에 긍정적인 영향을 미칠 수 있다. 특히 사용자들은 친숙한 가상 캐릭터들과 준사회적 (Parasocial) 관계를 맺을 수 있어[21], 자폐 아동의 사회적 성장과 정서 교육을 위해서도 쓰이고 있다[22]. 최근 한 연구팀은 3D 캐릭터의 무용 움직임이 표현하고자 하는 감정을 청자들에게 전달할 수 있는지에 대한 연구를 진행했다[23]. 노래가 없었음에도 불구하고 참가자들의 70% 이상이 음악의 감정을 바르게 추측했고, 캐릭터가 표현하는 감정이 청자의 감상 후 감정 상태에도 영향을 미쳤다. 이러한 연구들은 비언어적인 얼굴표정이나 신체 움직임을 통해 감정전이를 일으킬 수 있으며 특히 가상 캐릭터를 통할 경우 더 효과적으로 이루어질 수 있음을 암시한다.

2-3 음악에서 표정을 활용한 연구

음악 분야에서 얼굴 표정을 사용한 연구는 크게 얼굴 표정을 음악을 생성하기 위한 새로운 악기로 사용한 연구[24] 와 음악 감상에 보조적인 수단으로 사용한 연구로 나뉠 수 있다. 얼굴 표정을 음악 감상에서 감정 전달의 보조 수단으로 사용한 한 예로, EmotionFace는 연주되는 음악의 여러 특징에 따라 2D 얼굴 모델의 기하학적 수치를 변화시켜 표정을 바꾸는 시스템으로, 악곡 내 각성도 (Arousal) 와 정서가 (Valence) 값에 따라 기본적인 눈매와 입의 근육 움직임을 변화시키는 시스템이다[25, 26]. 이 연구에서는 기존 자기보고를 통해 미리 측정된 각성과 정서가만을 적용하였고, 기본적인 얼굴 움직임만을 표현할 수 있다는 한계점이 있었다. 이에 더 나아가 MusicFace 시스템은 같은 2차원 감정 모델을 3D 캐릭터에 적용시킨 것으로, 곡의 세기, 리듬, 조음 각각에 대해 정서가와 각성도를 측정하여 3D 애니메이션 캐릭터로 더 세심한 감정을 표현하려고 하였다[27]. 이러한 연구들은 음악에서 발견되는 기본적인 특징들을 임의로 표정으로 자동화하여 매핑시킨 방식으로, 음악의 섬세한 감정을 표현하기에는 부족하다는 한계를 지닌다.

본 연구는 음악에 대한 전문성을 갖추고 표정 연기를 훈련 받은 사람의 얼굴 표정을 실시간으로 인식, 캐릭터로 매핑시켜 청자에게 시각적 자극으로 전달함으로써 음악 감정 전달을 돕는 방식으로, 기존 방식과는 차별성을 지니며 아울러 그 효과성을 검증한 실증 연구로서 의의를 지닌다.

Ⅲ. 캐릭터 보조 음악 감상 시스템

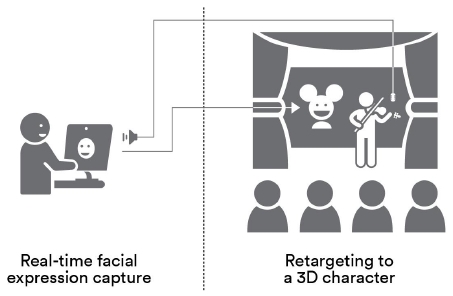

제안하는 시스템은 청중들이 무대를 바라보며 음악 감상을 하는 형태인 라이브 콘서트 환경에 적용하는 것을 목표로 디자인되었다. 시스템은 크게 캐릭터 생성, 배우의 표정 연기 캡쳐, 3D 캐릭터 얼굴 표정으로 리타게팅 하는 부분으로 구성된다.

3-1 캐릭터

캐릭터는 연주되는 곡의 분위기 및 청중의 연령대, 성별, 문화적 배경 등을 고려하여 선정된다. 콘서트의 성격에 맞는 캐릭터가 선정되면 3D 모델링과 리깅 작업을 통해 실시간 애니메이션을 준비하게 된다.

3-2 퍼포먼스 캡쳐

얼굴 표정 연기를 캡쳐하기 위한 배우 선정에는 해당 콘서트에서 연주되는 곡을 깊이 이해하는지, 감정을 얼굴 표정을 통해 전달하는 기술을 훈련 받았는지 고려한다. 배우는 무대에서 라이브로 연주되는 음악을 들으며 얼굴 표정 캡쳐 시스템의 카메라 앞에서 표정 연기를 하게 된다. 이 때 표정을 연기하는 배우가 청중석을 모니터링할 수 있게 하여, 캐릭터의 표정을 통해 청중과 실시간으로 교감하고, 라이브 공연 환경을 적극적으로 활용한다.

3-3 표정 리타게팅

인식된 배우의 머리 움직임과 얼굴 표정은 실시간으로 미리 준비한 3D 캐릭터 모델에 입혀진다. 실시간으로 생성된 3D 애니 메이션은 청중이 바라보며 음악을 감상하고 있는 무대 쪽에 렌더링된다. 이 캐릭터 표정에 기반한 감정 전이 유발 효과를 통해 새로운 음악 감상 경험을 제공하게 된다.

Ⅳ. 실험 방법

제안하는 시스템의 효과성을 검증하기 위해 특정 감정을 표현하는 음악, 가상 캐릭터의 존재 유무를 독립변인으로 하여 피실험자들의 감정 변화량을 알아보는 실험연구를 수행하였다.

4-1 독립 변수

본 실험에서는 타 대중 장르보다 감상자의 진입장벽을 가지고 있는 클래식 악곡을 실험 자극 음악으로 사용하였다. 실험에는 이전 다른 음악 심리 연구에서 특정 감정을 유도하는 것으로 검증된 클래식 악곡[28] 중 Symphony No. 70, D major, 1st Movement (Joseph Haydn)을 기쁨 자극으로, Adagio in G minor (Tomaso Albinoni)을 슬픔 자극으로 선정하여 각각의 곡을 3분 30초로 편집하였다. 대학생 11명을 대상으로 악곡을 들려주었을 때, 두 악곡 모두 참가자의 90% 이상이 표현하는 감정을 유발한다고 답했고, 기쁨 음악에 81.8%(9명), 슬픔 음악에 63.7%(7명)의 참가자들이 보통 이상의 강도를 느꼈다.

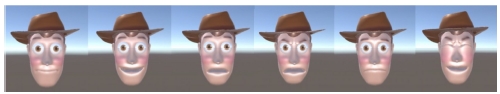

실험에 사용한 캐릭터는 명확한 표정 표현이 가능하고, 대중적으로 알려져 있으며, 정서적으로 친밀감이 높은 사람 모양의 캐릭터를 기준으로 선정하였으며, 픽사 애니메이션 <토이스토리>의 메인 캐릭터인 우디를 실험 캐릭터로 선택하였다(그림 2). Autodesk Maya를 사용하여 3D모델링과 리깅(Rigging) 작업을 수행하였다. 표정 캡쳐를 위해 클래식 음악에 대한 이해가 높고 얼굴 표정을 통해 감정전달 훈련을 받은 피아노 및 성악 전공 대학원생을 얼굴 표정 모델로 섭외하였다. 섭외된 모델은 선정된 음악을 미리 들어보며 음악 구조의 감정적 표현을 연습하도록 지시받았다. 실시간 모션 캡쳐 소프트웨어인 Faceware Live를 사용해 스튜디오에서 음악이 재생된 상태에서 배우의 표정 연기를 캡쳐하고(그림 3), 3D 우디 캐릭터의 표정으로 리타게팅하여 애니메이션을 생성하였다. 본 연구는 콘서트 등의 라이브 음악 감상에서 실시간 표정 생성을 전제로 하지만 실험에서는 실험 세션 간 애니메이션 질을 동일하게 유지하기 위해 애니메이션을 녹화하여 진행하였다.

4-2 종속 변수

본 연구에서는 Ekman이 Discrete Emotion Model[29]에서 제안한 여섯 가지 기본 인간 감정 중 기쁨과 슬픔 두 가지 감정에 대해서 제안한 방식의 효과성을 알아보았다. 실험에서는 기쁨과 슬픔 각 감정에 대해 설문지에 연관어를 추가적으로 제시하여 참가자들의 이해를 도왔으며, 각 감정별로 15cm VAS (Visual Analogue Scale)에 느낀 감정의 정도를 표시하게 했다.

음악 감상 중 음악의 구조와 멜로디 등 음악의 내부 요소에서 인지하여 느끼는 감정 (인지 감정, Recognized Emotion) 과, 청자가 음악을 수용한 후 개인적 경험 등의 영향을 받아 자발적으로 느끼는 감정 (반응 감정, Felt Emotion) 에는 그 기제와 강도에 차이가 있는 것으로 알려져 있다[30, 31]. 따라서, 연구팀은 기쁨 / 슬픔 감정 별로 15cm VAS 척도에 반응 감정은 실험 전후 자신의 현재 감정을, 인지감정은 감상 후 음악에서 인지된 감정의 강도를 표시하게 했다.

4-3 실험 과정

실험에는 인터넷 공고를 통해 모집한 20대 대학생 총 100명이 참가하였다. 클래식 음악 선호도에 따른 효과를 피하기 위해, 클래식 장르 선호도가 보통 수준보다 높다고 답변한 참가자들만을 대상으로 하였다. 실험집단(캐릭터 제시)과 통제집단(캐릭터 비 제시)에 각각 40명이 배정되었고, 나머지 20명은 캐릭터 표정의 효과를 추가적으로 알아보기 위해 표정이 음악과 싱크되지 않은 무표정 캐릭터 집단에 배정하였다. 실험집단과 통제집단은 각각 20명씩 기쁜 음악과 슬픈 음악 그룹으로 나누어 배정하여 총 다섯 개 그룹으로 참가자를 배정하였다. 각 집단은 남녀 비율(1:4)과 평균 나이 분포(21세)를 고려하였다.

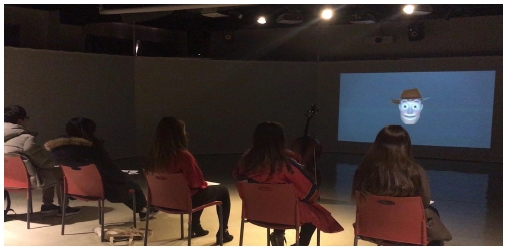

실험은 몰입 음악 감상이 가능한 실내 스튜디오에서 이뤄졌다. 멀티스크린이 설치된 실험실 가운데에 중앙 스크린에서 7m 떨어진 곳에 의자 5개를 배치했다. 스크린과 관람객과의 거리에 따른 영향을 최소화하기 위해 각 세션은 5명씩 진행되었다. 음악은 실험실 앞쪽 양 구석에 설치된 스피커를 통해 재생되었으며, 실험집단에 한해 음악에 맞추어 표정을 짓는 약 80cm 크기의 캐릭터 영상이 상영되었다.

실험실에 입장한 실험참가자들은 실험에 대한 간략한 설명을 듣고 동의서 작성 후 현재 감정을 15cm VAS에 표시했다. 설문지 작성 후, 약 3분 30초 길이의 음악을 실험집단은 캐릭터와 함께, 통제집단은 캐릭터 없이 감상했다. 음악 감상 후, VAS 척도로 현재 감정과 음악에서 인지되는 감정을 측정하고 추가로 경험 만족도, 몰입도를 5점 리커트 척도에 표시하게 하였다. 캐릭터 집단에서는 캐릭터 선호도와 캐릭터가 전체 경험에 미친 영향을 주관식으로 적게 하였다. 또한, 사용자 경험에 대해 보다 심층적으로 알아보기 위해 실험 참가자들 중 무작위로 20명에 대하여 심층 인터뷰를 진행하였다. 인터뷰는 약 20분 동안 진행되었으며, 1) 평소 음악 감상 형태, 2) 평소 캐릭터에 대한 인식, 3) 실험 중 캐릭터와 음악 감상 경험 등에 대해 질의 응답하였다.

Ⅴ. 실험 결과

5-1 정량 결과 분석

통제 집단과 실험 집단 간의 음악 청취 전후 반응 감정의 동질성을 검증하기 위해 기쁨, 슬픔 음악 집단에 대해 각각 독립표본 t-검증을 실시하였다. 두 종류 음악 모두에서 통제 집단과 실험 집단의 사전 반응 감정 간에 통계적으로 유의한 차이가 나타나지 않았다(표 1). 따라서 두 집단을 동질 집단으로 간주하였다.

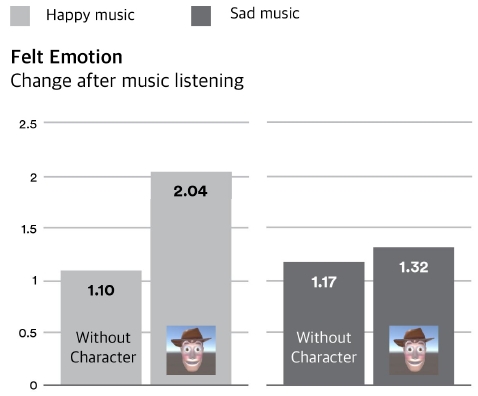

기쁜 음악 그룹의 통제 집단의 반응 기쁨에서는 음악 감상 전 사전 점수(M=6.11)와 음악 감상 후 사후 점수(M=7.21)간에 통계적으로 유의한 차이가 나타나지 않았다. 반면, 실험 집단의 반응 기쁨에서는 사전 점수(M=6.23)보다 사후 점수(M=8.27)가 높게 나타났으며 통계적으로도 유의한 차이를 보였다(t=-2.578, p<.05) (표 2) (그림 5). 슬픈 음악 그룹의 통제집단에서 반응 슬픔은 사전 점수(M=4.17)와 사후 점수(M=5.35)간에 통계적으로 유의한 차이가 나타나지 않았다. 반면, 실험 집단의 반응 슬픔에서는 사전 점수(M=2.49)보다 사후 점수(M=3.81)가 통계적으로 유의한 경향성을 보이며 높게 나타났다(t=-1.981, p=.062) (표 2). 이는 기쁨, 슬픈 음악 감상 시 음악에 맞게 표정을 짓는 캐릭터의 존재가 각각 참가자의 반응 기쁨 및 슬픔을 증가시키는데 어느 정도 영향을 줄 수 있음을 암시한다.

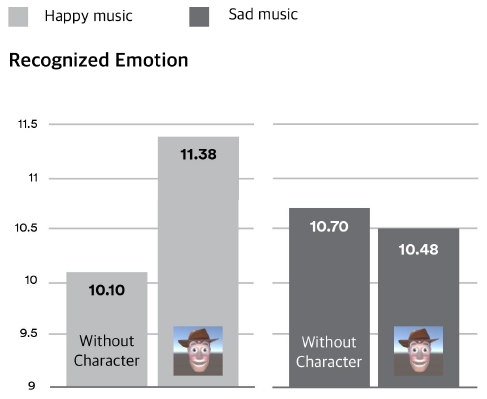

음악을 듣고 인지한 감정을 보고한 결과에서는, 기쁜 음악 그룹에서 캐릭터와 함께한 실험 집단 참가자들이(M=11.38) 통제 집단 참가자들(M=10.10)보다 기쁜 감정을 더 인지한 것으로 보고되었다. 반면 슬픈 음악 그룹에서는, 두 집단 간 거의 차이가 없었다 (그림 6).

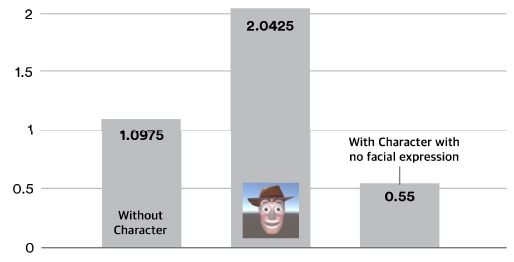

캐릭터와 함께 음악 감상을 한 실험 집단에서의 감정 변화에 음악과 연결된 캐릭터 표정이 미친 영향을 알아보기 위해 음악과 싱크되지 않은 무표정 캐릭터 영상 집단에 대해 추가적인 실험을 실시하였다. 이를 위해 통제 및 실험 집단의 사전사후 반응 감정 차이가 통계적으로 더 유의미하게 나타났던 기쁜 음악을 표정 없이 눈만 깜빡이는 캐릭터와 함께 20명에게 들려주었다. 실험 결과, 무표정 집단에서는 통계적으로 유의미한 감정변화가 보이지않았다 (그림 7). 이는 단순히 캐릭터의 존재가 아니라 캐릭터가 음악과 싱크된 표정을 표현한 부분이 청자에게 영향을 미쳤음을 암시한다.

5-2 인터뷰 결과

캐릭터와 함께 청취한 실험 집단 참가자를 대상으로 주관식 응답과 심층 인터뷰를 통해 전체적인 경험 만족도와 함께 음악 감상에 대한 긍정적, 부정적 피드백을 알아보았다. 긍정적인 피드백으로는 캐릭터의 흥미 유발 및 집중 유도 효과에 대한 언급이 가장 많았다. 대부분의 참가자들은 캐릭터의 시각적 모달리티 자체가 경험의 흥미를 높여 집중에 도움이 되었다고 보고했다.

“음악이 잔잔해지면 캐릭터도 움직임이 줄어들고, 음악이 세지거나 멜로디가 화려하게 변할 때면 캐릭터의 움직임도 그 변화에 따라 함께 격해졌던 것 같다. 그래서 더 음악에 몰입할 수 있었고, 더 좋았다.” (P09, 20세, 여성)

“클래식인데도 졸리게 느껴지지 않고 뭔가 재미있고, 즐거운 느낌으로 캐릭터를 따라갈 수 있었다. 또한 가끔 눈을 깜빡이는데, 그 순간마다 더 집중하게 되었다.” (P14, 20세, 여)

한편, 부정적인 피드백으로는 캐릭터의 그래픽 수준이나 부자연스런 움직임이 음악 감상에 방해가 되었다는 의견이 많았다.

“음악적 경험은 기계적이지 않은데, 그리고 음악의 흐름 역시 유기적이고 매끄럽게 흘러가야 되는데 캐릭터의 표정변화와 고개를 끄덕임 등의 행동은 그러한 음악의 면모를 빼앗았다.” (P07, 22세, 여성)

캐릭터와 음악장르의 매치에 대해서도 몇 차례 언급되었다. 또한, 몇몇은 캐릭터의 표정이 자신과 다른 감정을 표현하거나, 감정을 유도하거나, 음악의 감정표현을 단순화하는 것이 인식될 때 불편함을 느꼈다고 보고하였다.

“우디라는 캐릭터는 굉장히 좋아하지만 이 음악과는 조금 안 어울리는 이미지였고 … 음악과 별개로 그 이미지들이 떠올라 Distract하는 경향이 있었다.” (P13, 21세, 여성)

Ⅵ. 논 의

6-1 음악과 캐릭터

본 실험에서는 슬픈 음악 그룹보다 기쁜 음악 그룹에서 감정 변화가 더 많이 보고되었다. 슬픈 음악보다 기쁜 음악에서 감정이 더 반응한 결과는 선행 연구 결과에서도 확인되어진다. 일반적으로 청자들은 음악에 내포된 긍정적인 감정(사랑, 뿌듯함, 감탄 등)을 더 잘 인지하며, 부정적인 감정은 긍정적 감정과 비교했을 때 내적으로 느껴지기보다는 인지 수준에서 더 자주 머무는 것으로 보고되었다[32]. 캐릭터는 대부분의 참가자들에게 흥미를 유발하여 집중도를 높였으나, 일부 참가자들에게는 오히려 음악에 대한 집중력을 흐리게 하는 요인으로 작용하였다. 그 주요 요인으로는 클래식 음악에 대해 평소 조예가 깊고 자신의 고유한 감상방식이 있는 사람에게는 다른 부가적인 요소가 방해가 되었을 가능성을 추측할 수 있다. 그밖에 캐릭터의 선호도, 악곡과의 이미지 연관성, 그래픽 퀄리티, 표정 변화의 제한된 다양성 등이 영향을 미쳤을 것으로 추측된다.

6-2 제한점

본 실험 결과는 몇 가지 제한점을 가진다. 첫째, 이 실험은 20대 대학생들을 대상으로, 특정 캐릭터를 사용하여 진행되었기 때문에, 아동과 같은 다른 연령대나 다른 캐릭터로 결과를 일반화 시킬 수는 없다. 둘째, 실험에 사용된 3D 모델링과 애니메이션 퀄리티가 상용화된 애니메이션 수준이 아니기에 사용자들의 기대수준 보다 비교적 낮은 캐릭터 퀄리티가 실험 결과에 영향을 미쳤음을 배제할 수 없다. 이것은 심층 인터뷰에서도 부정적인 의견으로 보고되었는데, 이에 따라 추후 실험에서는 더 높은 그래픽 퀄리티로 실험을 진행할 필요가 있다.

Ⅶ. 결 론

본 논문에서는 감정전이 원리와 실시간 얼굴 표정 리타게팅 기술을 활용한 새로운 음악 감상 시스템을 제안하였다. 제안한 새로운 시스템에서 청자는 음악과 동시에 음악 감정을 실시간 얼굴 표정으로 연기하는 가상의 캐릭터를 시각적 자극으로 받게 된다. 실시간 캐릭터 얼굴 표정 애니메이션 생성은 카메라 기반의 모션 캡쳐 기술과 표정 리타게팅을 통해 실제 사람의 얼굴 표정 연기를 통해 이루어진다. 이 시스템은 라이브 음악 콘서트 등의 환경에서 실시간으로 상황에 따라, 청중에 따라, 캐릭터 애니메이션 생성을 할 수 있기에 새로운 엔터테인먼트 경험을 줄 수 있는 가능성을 지닌다. 또한 어려운 음악에 대한 음악적 감정을 보다 더 잘 전달하기 위해 사용되어 지거나, 청각장애인에게 음악을 시각적으로 전달하는데 도움을 주는 데 사용되어 질 수 있다. 20대 대학생 100명을 대상으로 한 실험 결과, 제안한 방식이 청자의 감정 상태에 더 큰 영향을 줄 수 있음을 확인하였다. 특히 기쁜 음악에서 통계적으로 유의미한 결과를 확인하였다.

향후 연구 방향으로는 머신러닝 기반으로 청자의 캐릭터 선호와 감성 모델 등을 학습하여 특정 청자의 감성에 가장 크게 호소할 수 있는 캐릭터로 외복/얼굴 표정을 음악에 맞게 자동으로 생성하는 방안을 고려할 수 있다. 이렇게 될 경우 사람의 연기에 의존하지 않기에 확장 가능한 방법이 되어 개개인이 자신의 디지털 기기에서 실시간으로 캐릭터와 음악을 같이 듣는 새로운 엔터테인먼트 경험을 제공할 수 있을 것이다.

References

-

T. Baumgartner, M. Esslen, and L. Jäncke, "From emotion perception to emotion experience: Emotions evoked by pictures and classical music", International Journal of Psychophysiology, 60(1), p34-43, (2006).

[https://doi.org/10.1016/j.ijpsycho.2005.04.007]

-

P. Juslin, and P. Laukka, "Expression, Perception, and Induction of Musical Emotions: A Review and a Questionnaire Study of Everyday Listening", Journal of New Music Research, 33(3), p217-238, (2004).

[https://doi.org/10.1080/0929821042000317813]

-

E. Nawrot, "The Perception of Emotional Expression in Music: Evidence from Infants, Children and Adults", Psychology of Music, 31(1), p75-92, (2003).

[https://doi.org/10.1177/0305735603031001325]

-

A. Ridley, "Musical Sympathies: The Experience of Expressive Music", The Journal of Aesthetics and Art Criticism, 53(1), p49, (1995).

[https://doi.org/10.2307/431736]

-

M. Terwogt, and F. Van Grinsven, "Musical Expression of Moodstates", Psychology of Music, 19(2), p99-109, (1991).

[https://doi.org/10.1177/0305735691192001]

-

S. Livingstone, R. Mühlberger, A. Brown, and A. Loch, "Controlling musical emotionality: an affective computational architecture for influencing musical emotions", Digital Creativity, 18(1), p43-53, (2007).

[https://doi.org/10.1080/14626260701253606]

- K. Ng, "Music via Motion: Transdomain Mapping of Motion and Sound for Interactive Performances", Proceedings of the IEEE, 92(4), p645-655, (2004).

- E. Hatfield, J. Cacioppo, and R. Rapson, "Emotional Contagion", Current Directions in Psychological Science, 2(3), p96-100, (1993).

-

A. McGuiness, and K. Overy, "Music, consciousness, and the brain: Music as shared experience of an embodied present", Music and consciousness: Philosophical, psychological, and cultural perspectives, p245-262, (2011).

[https://doi.org/10.1093/acprof:oso/9780199553792.001.0001]

-

P. Niedenthal, M. Brauer, J. Halberstadt, and Å. Innes-Ker, "When did her smile drop? Facial mimicry and the influences of emotional state on the detection of change in emotional expression", Cognition & Emotion, 15(6), p853-864, (2001).

[https://doi.org/10.1080/02699930143000194]

-

H. Li, et al., "Facial performance sensing head-mounted display", ACM Transactions on Graphics, 34(4), p47:1-47:9, (2015).

[https://doi.org/10.1145/2766939]

-

P. Juslin, "Cue utilization in communication of emotion in music performance: Relating performance to perception", Journal of Experimental Psychology: Human Perception and Performance, 26(6), p1797-1812, (2000).

[https://doi.org/10.1037/0096-1523.26.6.1797]

- R. Bresin, and A. Friberg, "Synthesis and decoding of emotionally expressive music performance", IEEE Conference Proceedings of IEEE International Conference on Systems, Man, and Cybernetics (SMC ‘99), 4, (1999).

-

A. Lamont, "University Students' Strong Experiences of Music: Pleasure, Engagement, and Meaning", Musicae Scientiae, 15(2), p229-249, (2011).

[https://doi.org/10.1177/102986491101500206]

-

M. Pignatiello, C. Camp, and L. Rasar, "Musical mood induction: An alternative to the Velten technique", Journal of Abnormal Psychology, 95(3), p295-297, (1986).

[https://doi.org/10.1037/0021-843x.95.3.295]

-

A. Greasley, A. Lamont, and J. Sloboda, "Exploring Musical Preferences: An In-Depth Qualitative Study of Adults' Liking for Music in Their Personal Collections", Qualitative Research in Psychology, 10(4), p402-427, (2013).

[https://doi.org/10.1080/14780887.2011.647259]

-

S. Liljeström, P. Juslin, and D. Västfjäll, "Experimental evidence of the roles of music choice, social context, and listener personality in emotional reactions to music", Psychology of Music, 41(5), p579-599, (2012).

[https://doi.org/10.1177/0305735612440615]

-

D. Västfjäll, P. Larsson, and M. Kleiner, "Emotion and Auditory Virtual Environments: Affect-Based Judgments of Music Reproduced with Virtual Reverberation Times", CyberPsychology & Behavior, 5(1), p19-32, (2002).

[https://doi.org/10.1089/109493102753685854]

-

K. Kamiyama, D. Abla, K. Iwanaga, and K. Okanoya, "Interaction between musical emotion and facial expression as measured by event-related potentials", Neuropsychologia, 51(3), p500-505, (2013).

[https://doi.org/10.1016/j.neuropsychologia.2012.11.031]

-

W. Thompson, P. Graham, and F. Russo, "Seeing music performance: Visual influences on perception and experience", Semiotica, 2005(156), (2005).

[https://doi.org/10.1515/semi.2005.2005.156.203]

-

K. Brunick, M. Putnam, L. McGarry, M. Richards, and S. Calvert, "Children’s future parasocial relationships with medi characters: the age of intelligent characters", Journal of Children and Media, 10(2), p181-190, (2016).

[https://doi.org/10.1080/17482798.2015.1127839]

- Y. Cheng, and S. Ling, "3d animated facial expression and autism in taiwan", IEEE International Conference on Advanced Learning Technologies, 8, p17-19, (2008).

-

J. Roxas, D. Richards, A. Bilgin, and N. Hanna, "Exploring the influence of a human-like dancing virtual character on the evocation of human emotion", Behaviour & Information Technology, 37(1), p1-15, (2017).

[https://doi.org/10.1080/0144929x.2017.1386714]

- M. Lyons, and N. Tetsutani, "Facing the music: a facial action controlled musical interface", CHI 2001 Extended Abstracts, (2001).

-

E. Schubert, "Measuring Emotion Continuously: Validity and Reliability of the Two-Dimensional Emotion-Space", Australian Journal of Psychology, 51(3), p154-165, (1999).

[https://doi.org/10.1080/00049539908255353]

- E. Schubert, "EmotionFace: Prototype facial expression display of emotion in music", Georgia Institute of Technology, (2004).

-

S. DiPaula, and A. Arya, "Emotional remapping of music to facial animation", Proceedings of the 2006 ACM SIGGRAPH symposium on Videogames, (2006).

[https://doi.org/10.1145/1183316.1183337]

-

E. Bigand, and S. Filipic, "The Time Course of Emotional Responses to Music", Annals of the New York Academy of Sciences, 1060(1), p429-437, (2005).

[https://doi.org/10.1196/annals.1360.036]

- P. Ekman, "Expression and the nature of emotion", Approaches to emotion, 3, p19-344, (1984).

-

P. Evans, and E. Schubert, "Relationships between expressed and felt emotions in music", Musicae Scientiae, 12(1), p75-99, (2008).

[https://doi.org/10.1177/102986490801200105]

-

E. Schubert, "Emotion felt by the listener and expressed by the music: literature review and theoretical perspectives", Frontiers in Psychology, 4, (2013).

[https://doi.org/10.3389/fpsyg.2013.00837]

-

M. Zentner, D. Grandjean, and K. Scherer, "Emotions evoked by the sound of music: characterization, classification, and measurement", Emotion, 8(4), p494, (2008).

[https://doi.org/10.1037/1528-3542.8.4.494]

저자소개

2017년: 서강대학교 (예술공학학사)

2019년: 미국 미시건대 대학원 (공학석사-정보학)

※관심분야: 휴먼-컴퓨터 인터랙션, 유비쿼터스 컴퓨팅

2000년: 연세대학교 (공학학사-전자공학)

2002년: 연세대학교 대학원 (공학석사-전자공학)

2008년: 미국 메릴랜드대 대학원 (공학박사-컴퓨터공학)

2008년~2012년: 미국 Rhythm & Hues Studios

2012년~현재: 서강대학교 아트&테크놀로지 전공 교수

※관심분야: 크리에이티브 컴퓨팅, 휴먼-컴퓨터 인터랙션, 뉴미디어 등